9月17日消息,据Mysten Labs联合创始人兼首席执行官Evan.sui在X平台转发该公司消费者合作及投资负责人Jameel.sui相关内容显示,Sui已与Circle达成合作,USDC即将拓展至Sui Network。

All posts by ayu

PeerDAS 将如何改进以太坊的数据可用性?

来源:chainfeeds

在最近的以太坊开发者会议上,讨论了将以太坊的 Pectra 硬分叉分成两部分的提议。这个提议之前曾经被否决,因为大家担心会延迟 Verkle 树的升级。不过在这次的会议上,开发者们再次提出了这个想法,因为他们希望在 Pectra 分叉中加入更多的改进提案(EIP)。提议将硬分叉分为两部分:第一部分将包括目前 Pectra Devnet 3 上的所有 EIP,第二部分的分叉将包括 EOF(EVM 对象格式)和 PeerDAS 等,为了更好地理解 PeerDAS,我们首先从数据可用性这一基础概念讲起。

DA:确保节点获取链上数据

数据可用性(Data Availability,DA)是指要保证区块提议者发布的区块、区块中所包含的所有交易数据,对于其他网络参与者来说可以有效地访问和获取。数据可用性是区块链安全的一个关键因素,因为如果数据不可用,即使区块合法,其他节点也无法验证其内容,可能引发共识问题和网络攻击。例如,攻击者可能只发布部分区块数据,导致其他节点无法进行验证。

当新区块被广播时,所有参与的节点都会下载并验证区块的数据。这种模式在网络规模较小时是可行的,但随着区块链的不断增长,数据量会变得非常庞大,每个节点存储会不断增加,对硬件的要求随之提高。为了让轻节点(如手机或电脑这样的移动设备)也可以参与区块验证,区块链引入了分片技术。

分片技术是将整个区块链网络分成多个小的「片」(shards)。每个分片只处理自己那部分数据,不必处理整个区块链的数据。因此,单个节点只需要处理自己分片的数据。但每个分片只处理一部分数据,就意味着其他分片的节点无法直接访问完整的数据。那如何确保分片中的数据是可用的,并且其他节点能够验证这些数据的有效性?例如,某个分片的节点发布了一个新生成的区块,但它可能只发布了一部分数据。如果其他节点无法获取区块的全部数据,就无法验证这个区块是否真实合法。

DAS:通过部分数据验证整体数据可用性

为了应对分片中的数据可用性问题,数据可用性抽样(Data Availability Sampling,DAS)技术被提出,它的核心思想是通过抽样的方式来验证区块的数据可用性,不要求每个节点存储或下载完整的区块数据。

数据可用性抽样允许节点只需随机获取区块中的一部分数据便可以验证数据可用性,如果节点能够成功获取并验证这些随机数据片段,便可以推测整个区块的数据是可用的。

为了支持这种抽样验证,区块数据通常会使用 RS 编码。这种编码允许在丢失部分数据的情况下仍然能够恢复出完整的数据。因此,即使节点仅下载部分区块数据,也能够推断并确认整个区块数据的有效性。DAS 通过抽样验证减少了每个节点需要处理的数据量,轻节点也可以参与区块验证。

DA 层比如 Celestia 的就是通过这些技术来实现。主要涉及 RS encoding + validity proof + DAS。

-

RS 编码(Reed-Solomon Encoding):这种编码方式允许只接收到一部分数据片段的节点也能够重建整个数据块。它类似于纠错码,具有一定的容错能力,即便丢失一部分数据,剩下的部分也足以重构完整数据。

-

Validity Proof(有效性证明):使用零知识证明来确保数据在编码和传输的过程中没有错误。如果验证成功,则可以无误地解码出整个数据。

-

DAS(数据可用性抽样):通过轻节点随机抽样区块中的一部分 RS 编码片段,验证这些片段的可用性,从而推测整个数据块是可用的。

PeerDAS: 节点间协作验证数据

PeerDAS 是 DAS 的一种具体实现,通过对等网络(peer-to-peer network)进行数据可用性抽样,对等网络是由多个节点组成的网络,节点间直接进行通信。在 DAS 下,每个节点独立进行数据的抽样验证,而 PeerDAS 优化了这一过程,它让节点之间协作共享和验证区块中的数据,进一步提高验证效率。节点之间并不是孤立的,可以共享数据验证的任务和结果,可以依赖其他节点已验证的数据。这样,节点不必单独承担所有的验证工作,而是通过合作分担验证任务,进一步减少节点的负担。而且协作验证增加了数据篡改的难度,攻击者需要同时影响多个验证节点才能成功篡改数据。

目前,根据最新以太坊关于 PeerDAS 的会议,以太坊客户端 Lighthouse 团队已经将 DAS 分支合并到主分支,并正在测试以确保与 PeerDAS 的兼容性。分支通常是用来开发和测试新功能或改进的独立代码版本,合并到主分支意味着这个功能或改进已经开发完成,并且有信心是稳定的,可以合并到核心代码中。

Gavin Wood在新加坡的演讲:Polkadot JAM

本文是根据Gavin Wood2024年9月16日在新加坡Polkadot Decoded Asia演讲时所展示的PPT翻译而成。

Lemma 1:All stable social systems need forms of governance

引理1: 所有稳定的社会系统都需要治理形式。

Lemma 2: Democratic mechanisms are essential apparatus of governance

引理2: 民主机制是治理的基本工具。

Lemma 2b: Democratic mechanisms are essential apparatus of governance within the Free World

引理2.1: 民主机制是自由世界中治理的基本工具。

Lemma 3: Humanity is fast transitioning to the digital realm

引理3: 人类正在快速向数字领域转型。

Lemma4: Web3 is the norms and principles of the Free World applied to the digital realm

引理4: Web3是自由世界的规范和原则在数字领域的应用。

Lemma 5: Without strong individuality, democratic mechanisms are impossible

引理5: 没有强烈的个性,民主机制就不可能实现。

Consider: If l am having a conversation with someone, and I cannot tell whether it is a human or an Al-that’s the end of democracy. CPakndn Yuval Noah Hariri(The Economist, 28/04/23)

思考:如果我在和某人交谈,而我无法分辨他是人类还是人工智能——这就是民主的终结。——Yuval Noah Harari(《经济学人》,2023年4月28日)

Lemma 6: Blockchain systems are social systems

引理6: 区块链系统是社会系统。

Lemma 6b: Blockchain systems capable of evolution are social systems

引理6.1: 能够进化的区块链系统是社会系统。

Conclusion: Blockchains need Strong Individuality to survive. The Free World needs Web3 and Strong Individuality to survive.

Individuality cuts close to the bone It might send a shudder down your spine

结论: 区块链需要强烈的个性才能生存。自由世界需要Web3和强烈的个性才能生存。

Individuality vs Identity

Identity aids in linking my interactions; it compromises my digital self. Pervasive strong identity is the despot’s dream.

Individuality only demonstrates my uniqueness; it allows me to strongly exercise my rights without fear. It is the despot’s nightmare.

Beware Identity solutions posing as Individuality products.

个性与身份的区别:

身份:帮助连接我的交互,但会损害我的数字自我。普遍且强大的身份是暴政者的梦想。

个性:仅展示我的独特性,允许我强烈地行使我的权利而无所畏惧。它是暴政者的噩梦。

注意事项: 警惕那些以个性产品自居的身份解决方案。

Examples of Individuality- Identity leakage.

Proof-of-age

Crypto purchases

Basically all voting

Foreign-exchange services

Any time you’re asked for a credit card online

个性的例子: 身份证明泄露、年龄证明、加密货币购买、基本投票、外汇服务等。

The Nature of Digital Individuality Individuality is a social, not logical, construct Ergo, not “provable” with math Therefore it must be discovered and consensus over its validity found No Silver Bullet

数字个人主义的本质:个人主义是一种社会而非逻辑的构建,因此无法用数学“证明”,必须通过发现和达成一致意见来确定其有效性。没有万灵丹。

The Nature of Digital Individuality ·Enlightened discovery implies evidence collection, evaluation & judgement Web3 principles imply no reliance on trust: Evidence must be primary source Evidence must be open for all to evaluate.Principle of universality implies a single judgement

数字个人主义的本质:启蒙发现意味着收集证据、评估和判断。Web3 原则意味着不依赖信任:证据必须是原始来源,必须对所有人开放评估。普遍性原则意味着一个单一的判断。

The Nature of Digital Individuality We must find consensus on: kinds of evidence; evaluation criteria; 。 how to arrive at a judgement.

数字个人主义的本质:我们必须就以下方面达成一致:证据的类型、评估标准、如何做出判断。

The Nature of Digital Individuality A Digital Individuality Mechanism is really just a definition for this collection, evaluation &judgement.

数字个人主义的本质:数字个人主义机制实际上只是对这种收集、评估和判断的定义。

Designed for Privacy.Privacy when proving individuality Unique unlinkable alias for every context in which individuality is used Unlinkable to financial events

设计注重隐私:在证明个人身份时保护隐私,每个用于个人身份的上下文中都有独特的、不可链接的别名,不可链接到财务事件。

Designed to Scale.Initial design scales to over a million Design improvements to deliver billions

设计注重可扩展性:初始设计可扩展到超过一百万,设计改进可交付数十亿。

Designed to Work Against the Odds .No reliance on governments. No reliance on Web2 platforms. No reliance on special hardware..No central key-keeper. No common confessional. No trust.

设计注重对抗困难:不依赖政府、不依赖 Web2 平台、不依赖特殊硬件、没有中央密钥保管人、没有共同的忏悔室、没有信任。

Technology Bulletin Chain:1TB of secure web-accessible decentralized data-storage for Polkadot system. Small Statements Hub: Decentralized private off-chain web-accessible pub/sub database for small messages sent between accounts.

Technology Relay PubSub:Fast and easy publication and subscription of small data between parachains..TransactionExtension: Low-level support for strongly private transactions, signed only with a zk-proof.

Technology

RingVRF: zk-SNARK-based cryptographic privacyprimitive allowing strong privacy within a groupVouchers Pallet: Privacy layer for system(treasury) payments to ensure unlinkabilitybetween reason and destination of payment

技术

-

Bulletin Chain: Polkadot 系统的 1TB 安全、可访问的去中心化数据存储。

-

Small Statements Hub: 一个去中心化的私有、离链、可访问的发布/订阅数据库,用于在账户之间发送小消息。Relay PubSub: 在平行链之间快速、轻松地发布和订阅小数据。

-

TransactionExtension: 对高度私密的交易提供低级别的支持,仅使用 zk-proof 进行签名。

-

RingVRF: 基于 zk-SNARK 的加密隐私原语,允许在组内实现强大的隐私。

-

Vouchers Pallet: 系统(国库)支付的隐私层,以确保支付的原因和目的地之间不可链接。

Integration

Easy private Polkadot-ecosystem-wide Sybil-resistence

let alias = ensure_person(origin, b”My context”)?;Kusama has same APl.

EVM parachains and Ethereum ecosystem whichsupport appropriate crypto will also have an EVM API.

集成

易于实现私有的、抗女巫攻击的 Polkadot 生态系统范围内的别名

-

let alias = ensure_person(origin, b"My context")?; -

Kusama 具有相同的 API。

-

支持适当加密的 EVM 平行链和以太坊生态系统也将具有 EVM API。

For keys, a new zk-SNARK-based cryptographicprimitive, the RingVRF is used.

Based on Bandersnatch cryptography used in JAM &Sassafras, wallets and chains can integrate easily inorder to let individuals prove unlinkable individualityWorking on compatibility with major EVM chains.

-

对于密钥,使用了一种新的基于 zk-SNARK 的加密原语,即 RingVRF。

-

基于 JAM 和 Sassafras 中使用的 Bandersnatch 加密,钱包和链可以轻松集成,以便让个人证明不可链接的个人身份。

-

正在研究与主要 EVM 链的兼容性。

DIM1

The first of three Digital Individuality Mechanismsdeveloped by Parity.This is the most invasive, but also requires the leastmaintenance and can be done remotely.

DIM1

-

Parity 开发的三种数字个人身份机制中的第一种。

-

这是最具侵入性的,但也需要最少的维护,并且可以远程完成。

DIM1:Proof-of-Ink

eA tattoo at a universal place on the body……of a unique design assigned on-chain usingtrustless entropy……evidence is final 3 minute video of tattooing….iudgement by common vote over citizenry.

DIM1:纹身证明

-

在身体上的一个通用位置纹上一个独特的纹身设计,该设计使用无信任熵在链上分配……证据是纹身过程的 3 分钟视频……由公民的共同投票做出判断。

Proof-of-Ink: Design FamiliesChoose from a selection within each of severalalgorithmic design families. if you don’t like any, you

get a new selection every day

The design range is extensible through governance

纹身证明:设计家族

-

从多个算法设计家族中的每个家族中的选择中选择。

-

如果你不喜欢任何一个,你每天都会得到一个新的选择。

-

设计范围可以通过治理进行扩展。

Entropretty application available now for anyone toplay with!Code a cool design and submit a PR to GH repo

Entropretty 应用程序现在可供任何人玩耍!

编写一个酷炫的设计并提交一个 PR 到 GH 仓库。

Strong Individuality Unlocks..

Mob Rule activity rewards

ePan-ecosystem username

Free decentralized storage

Airdrops

Event registration

Forums & channels

Specialized NFTS

Special financial products

Free transactions

Lotteryo

Remuneration

Enhanced governance:

Quadratic Voting?

Democratic Fund?

强大的个人主义解锁

-

群众规则活动奖励

-

ePan 生态系统用户名

-

免费去中心化存储

-

活动注册

-

论坛和频道

-

专门的 NFT

-

特殊的金融产品

-

空投

-

免费交易

-

彩票

-

报酬

-

二次投票(Quadratic Voting)

-

民主基金(Democratic Fund)

Strong Individuality Unlocks…

Al-resistantdemocracy

强大的个人主义解锁

人工智能抗拒的民主

从物理耗散系统的视角观察 Ponzi 盘

作者:ningning

在当今的加密行业,“质疑Ponzi”常被视为天真幼稚,而“理解Ponzi、成为Ponzi”逐渐成为主流理念。在这样的氛围下,Loki老师的新作宛如一束照进柏拉图洞穴的光,提醒我们这个行业需要回过头来,正视现实世界,解决真实问题。

尽管“盘学”(即Ponzi式商业模式)在加密圈盛行,我始终不认为Ponzi会是加密行业的最终归宿。再精巧的Ponzi模式,本质上也只是一个物理耗散系统,必须不断从外部输入能量或资源,才能维持其结构和功能。

从物理耗散系统的视角看Ponzi

Ponzi模式可以通过物理学中的“耗散系统”理论来理解。在这种系统中:

-

“低熵”能量:新投资者的资金注入。

-

系统的“有序结构”:投资者的金字塔分层设计。

-

“高熵”废物:资金流失和市场信任的损耗。

-

能量质量降低:随着时间推移,维持相同回报率需要更多新资金。

-

外部资源有限:潜在投资者群体终究是有限的。

-

熵积累:随着信任的下降,市场整体的熵值上升。

-

结构维护成本上升:吸引新投资者的成本越来越高。

任何耗散系统,终究会因无法获取足够的低熵能量而崩溃,Ponzi模式也不例外。这不是偶然的失败,而是熵增定律作用的必然结果。

加密行业的现状与挑战

加密行业能发展至今,离不开比特币早期的OG们布道,也离不开如A16Z、Pantera等顶级风投机构的推动。他们通过不断制造新叙事、构建新原语,一方面创造新的投资机会,另一方面吸引新资金入场,然后在牛市周期退出。从“盘学”的视角来看,这是一种复杂的Ponzi模式,它依赖于新投资者的不断进入。

然而,这种模式如今可能已接近其耗散系统的极限。一个明显的例子是,在美国市场,加密货币的渗透率已超过20%。当新资金来源枯竭,Ponzi系统必将瓦解。

突破困境的关键:创新与价值创造

要想打破这一局面,行业需要回归本质——构建持续创新、提升效率、创造实际价值的项目。创新、效率的提高和价值的创造,能够让系统维持在“远离平衡”的状态,这种状态下,系统有机会产生新的、有机的结构与功能,进而增强其可持续性。

加密行业急需一次“ChatGPT”时刻——一个能够真正推动技术与应用变革的突破。最近兴起的赛道,如PayFi、Consumer Chain、AI Agent with Crypto Wallet、链抽象等,正是在这种环境压力下诞生的新解决方案。

反思与回归:评估项目的真正价值

在评估这些项目的价值时,我们需要反思当前流行的“技术决定论”、“背景决定论”和对基础设施(Infra)的盲目崇拜。更重要的是,要回归产品本身以及其增长潜力。真正的价值创造不是依赖叙事和资金推动,而是源于产品的实际应用与用户增长。

深度解析 Multi-Agent:Web3 与 AI 终将相互成就?

如果说 AIGC 开启了内容生成的智能时代,那么 AI Agent 则有机会把 AIGC 的能力真正产品化。

AI Agent 像一位更具象的全能员工,被称为是人工智能机器人的初级形态,能够如同人类一般观察周遭环境、做出决策,并自动采取行动。

比尔·盖茨曾直言,“掌控 AI Agent,才是真正的成就。届时,你将不再需要亲自上网搜索信息。”AI 领域的权威专家们同样对 AI Agent 的前景寄予厚望。微软 CEO 萨提亚·纳德拉曾预言,AI Agent 将成为人机交互的主要方式,能够理解用户需求并主动提供服务。吴恩达教授亦预测,在未来的工作环境中,人类和 AI Agent 将以更加紧密的方式协作,形成高效的工作模式,提高效率。

AI Agent 不单是技术的产物,更是未来生活与工作方式的核心。

这不禁让人回想,当 Web3 和区块链刚引起广泛讨论时,人们也常常用”颠覆”一词来形容这项技术的潜力。回顾过去几年,Web3 从最初的 ERC-20、零知识证明,逐渐发展到了与其他领域相融合的 DeFi、DePIN、GameFi 等。

若将 Web3 与 AI 这两大热门数字科技相结合,会不会产生 1+1>2 的效果呢?融资规模越来越庞大的Web3 AI 项目,能否为行业带来新的用例范式,创造新的真实需求?

AI Agent:人类最理想的智能助手

AI Agent 的想象力到底在哪里?网上盛传一个高分答案,“大语言模型只能编个贪吃蛇,而 AI Agent 可以编出一整个王者荣耀。”听起来很夸张,但并未言过其实。

Agent,国内通常翻译为“智体”。这一概念由“人工智能之父” Minsky 在 1986 年出版的《思维的社会》一书中提出,Minsky 认为社会中的某些个体经过协商之后可得出某一问题的解,这些个体就是 Agent。多年来,Agent 一直是人机交互的基石,从微软的剪辑助手 Clippy 到 Google Docs 的自动建议,这些早期形态的 Agent 表现出了个性化交互的潜力,但在处理更复杂任务方面能力仍然有限。直到大语言模型(LLM)的出现,Agent 的真正潜力才得以被挖掘。

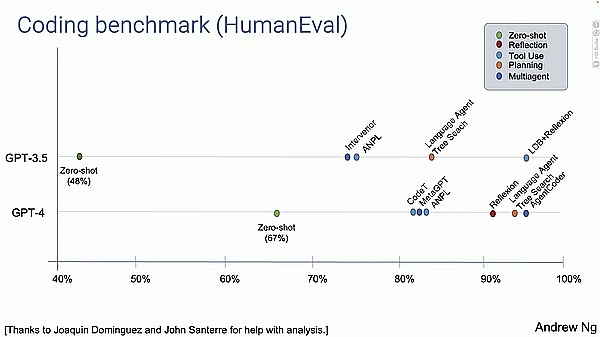

今年 5 月,AI 领域权威学者吴恩达教授在美国红杉 AI 活动上分享了关于 AI Agent 的演讲,在其中,他展示了其团队做的一系列实验:

让 AI 去写一些代码并运行,对比不同 LLM 和工作流程得出的结果。结果如下:

-

GPT-3.5 模型:准确率 48%

-

GPT-4 模型:准确率 67%

-

GPT-3.5 + Agent:高于 GPT-4 模型的表现

-

GPT-4 + Agent:远高于 GPT-4 模型,非常出色

的确。大多数人在使用 ChatGPT 这种 LLM 时,方式通常是:输入一段提示词,大模型会立即生成答案,不会自动识别和纠正错误删除重写。

相比之下,AI Agent 工作流程是这样的:

首先,先让 LLM 写一个文章大纲,如有必要,先在互联网上搜索内容进行调研分析,输出初稿,然后阅读草稿并思考如何优化,如此循环往复、多次迭代,最终输出一篇逻辑严谨、错误率最低的高质量文章。

我们可以发现,AI Agent 与 LLM 的区别在于,LLM 与人类之间的交互基于提示词(prompt)进行。而 AI Agent 仅需设定一个目标,它就能够针对目标独立思考并做出行动。根据给定任务详细拆解出每一步的计划步骤,依靠来自外界的反馈和自主思考,自己给自己创建 prompt,来实现目标。

因此 OpenAI 对 AI Agent 的定义是:以 LLM 为大脑驱动,具有自主理解感知、规划、记忆和使用工具的能力,能自动化执行完成复杂任务的系统。

当 AI 从被使用的工具变成可以使用工具的主体,就成为了 AI Agent。这也正是 AI Agent 可以成为人类最理想智能助手的原因所在。例如,AI Agent 能够基于用户历史线上互动,了解并记忆用户的兴趣、偏好、日常习惯,识别用户的意图,主动提出建议,并协调多个应用程序去完成任务。

就如同在盖茨的构想中,未来我们不再需要为不同的任务切换到不同的应用中,只需用平常的语言告诉电脑和手机想做什么,根据用户愿意共享的数据,AI Agent 将提供个性化的响应。

单人独角兽公司正在成为现实

AI Agent 还能够帮助企业打造以“人机协同”为核心的智能化运营新模式。越来越多的业务活动将交由 AI 来完成,而人类则只需要聚焦于企业愿景、战略和关键路径的决策上。

就像 OpenAI 首席执行官 Sam Altman 曾在采访中提到过这样一个引人注目的观点,随着 AI 的发展,我们即将进入“单人独角兽”时代,即由单人创办并达到 10 亿美元估值的公司。

听起来天方夜谭,但在 AI Agent 的助力下,这个观点正在成为现实。

不妨做个假设,现在我们要创办一家科技初创公司。按照传统方法,显然我需要雇佣软件工程师、产品经理、设计师、营销人员、销售和财务人员,各司其职但都由我来协调。

那么如果使用 AI Agent 呢,我可能甚至都不需要雇佣员工。

-

Devin — 自动化编程

替代软件工程师,我可能会使用今年爆火的 AI 软件工程师 Devin,它能帮我完成所有前端和后端的工作。

Devin 由 Cognition Labs 开发,被称为是“世界上第一个 AI 软件工程师”。它能够独立完成整个软件开发工作,独立分析问题、做出决策、编写代码并修复错误,均可自主执行。大大减轻了开发人员的工作负担。Devin 在短短半年内就获得了 1.96 亿美元的融资,估值迅速飙升至数十亿美元,投资方包括 Founders Fund、Khosla Ventures 等知名风险投资公司。

虽然 Devin 仍未推出公开版本,但我们可以从另一个最近爆火 Web2 的产品 Cursor 一窥潜力。它几乎可以为你完成所有工作,将一个简单的想法在几分钟内转化为功能性代码,你只需要发号施令,就能「坐享其成」。有报道称,一个八岁的孩子,在没有任何编程经验的情况下,居然使用 Cursor 完成代码工作并建起了一个网站。

-

Hebbia — 文件处理

替代产品经理或财务人员,我可能会选择 Hebbia,它能帮我完成所有文档的整理和分析。

与 Glean 侧重企业内文档搜索不同,Hebbia Matrix 是一个企业级的 AI Agent 平台,借助多个 AI 模型,帮助用户高效地提取、结构化、分析数据和文档,从而推动企业生产力的提高。令人印象深刻的是,Matrix 能一次性处理多大数百万份文档。

Hebbia 在今年 7 月完成了 1.3 亿美元 B 轮,a16z 领投,Google Ventures、Peter Thiel 等知名投资者参投。

-

Jasper AI — 内容生成

替代社媒运营和设计师,我可能会选择 Jasper AI,它能帮我完成内容的生成。

Jasper AI 是一个 AI Agent 写作助手,旨在帮助创作者、营销人员和企业简化内容生成流程,提高生产力和创作效率。Jasper AI 能够根据用户要求的风格生成多种类型的内容,包括博客文章、社交媒体帖子、广告文案和产品描述等。并根据用户的描述生成图片,为文本内容提供视觉辅助。

Jasper AI 已获得 1.25 亿美元的融资,并在 2022 年达到了15 亿美元的估值。根据统计数据,Jasper AI 已帮助用户生成超过 5 亿个单词,成为使用最广泛的 AI 写作工具之一。

-

MultiOn — 网页自动化操作

替代助理,我可能会选择 MultiOn,帮我管理日常任务、安排日程、设置提醒,甚至是规划出差行程,自动预订酒店,自动安排网约车。

MultiOn 是一个自动化的网络任务 AI 代理,能够帮助在任何数字环境中自主执行任务,例如帮助用户完成在线购物、预约等个人任务,提升个人效率,或帮助用户简化日常事务,提高工作效率。

-

Perplexity — 搜索、研究

替代研究员,我可能会选择英伟达 CEO 都在每天使用的 Perplexity。

Perplexity 是一个 AI 搜索引擎,能够理解用户的提问,拆分问题,然后搜索和整合内容,生成报告,以向用户提供清晰的答案。

Perplexity 适用于各类用户群体,例如学生和研究人员可以简化写作时的信息检索流程,提高效率;营销人员可以获取可靠数据支持营销策略。

以上内容仅为想象,当下这些 AI Agent 的真正能力和水平尚不足以替代各行各业中的精英人才。正如 Logenic AI 联合创始人李博杰所言,目前 LLM 的能力还只是入门级水平,远远达不到专家级,现阶段的 AI Agent 更像是一个干活比较快但不太可靠的员工。

然而,这些 AI Agent 凭借各自的特长,正在助力现有用户在多样化场景中提高效率和便利性。

不仅仅限于科技公司,各行各业都可以在 AI Agent 的浪潮中获得益处。在教育领域,AI Agent 可以根据学生的学习进度、兴趣和能力提供个性化的学习资源和辅导;在金融领域,AI Agent 可以帮助用户管理个人财务,提供投资建议,甚至预测股票走势;在医疗领域,AI Agent 可以帮助医生进行疾病诊断和治疗方案的制定;在电商领域,AI Agent 还可以作为智能客服,通过自然语言处理和机器学习技术自动回答用户咨询,处理订单问题和退货请求,以此提高客户服务效率。

Multi-Agent:AI Agent 的下一步

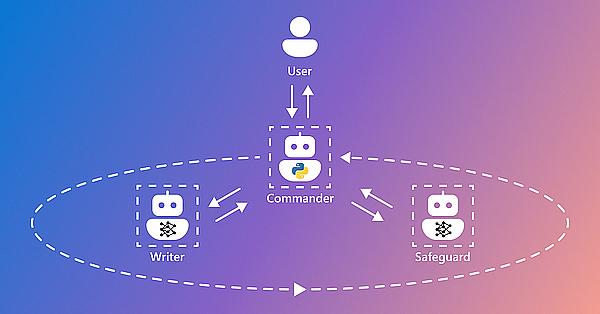

在上一节关于单人独角兽公司的设想中,单一的 AI Agent 在处理复杂任务时面临着局限性,难以满足实际需求。而运用多个 AI Agent 时,由于这些 AI Agent 基于异构 LLM,集体决策困难,能力有限,以至于还需要人类充当这些独立 AI Agent 之间的调度员,协调这些服务于不同应用场景的 AI Agent 去工作。这便催生了“Multi Agent(多智体框架)”的兴起。

复杂问题往往需要融合多方面的知识和技能,而单个 AI Agent 的能力有限,难以胜任。通过将不同能力的 AI Agent 进行有机组合,Multi-Agent 系统可以让 AI Agent 发挥各自的长处,取长补短,从而更有效地解决复杂问题。

这非常类似于我们实际中的工作流程或组织结构:由一个领导者分配任务,拥有不同能力的人,负责不同的任务,每个工序执行的结果给到下一个工序,最终得到最后的任务成果。

在实现过程上,由较低级别 AI Agent 执行各自的任务,而由级别较高的 AI Agent 分配任务,并对它们的完成情况进行监督。

Multi-Agent 还能模拟我们人类的决策过程,就像我们遇到问题时会找人商量一样,多个 AI Agent 也可以模拟集体决策的行为,为我们提供更好的信息支持。例如由微软开发的 AutoGen 就满足了这一点:

-

能够创建不同角色的 AI Agent。这些 AI Agent 具有基本的对话能力,能够根据接收到的消息,生成回复。

-

通过 GroupChat 来创建由多个 AI Agent 参与的群聊环境,在这个 GroupChat 有一个管理员角色的 AI Agent 管理其他 AI Agent 的聊天记录、发言者顺序、终止发言等。

如果应用到单人独角兽公司的设想里,我们可以通过 Multi-Agent 架构创建几个不同角色的 AI Agent,比如项目经理、程序员或者主管。把我们的目标告诉它们,让它们任意去想办法,我们只要在一旁听汇报,如果觉得有意见或者它们做得不对的地方,就让它们改,直到满意为止。

相比单一的 AI Agent,Multi-Agent 可以实现:

-

可扩展性:通过增加 AI Agent 的数量来处理更大规模的问题,每个 AI Agent 处理任务的一部分,使得系统能够随着需求的增长而扩展。

-

并行性:天然支持并行处理,多个 AI Agent 可以同时在问题的不同部分上工作,从而加速了问题解决。

-

决策改进:通过聚合多个 AI Agent 的洞察力来增强决策制定,因为每个 AI Agent 都有自己的视角和专业知识。

随着 AI 技术的不断进步,可以想象 Multi-Agent 框架将在更多行业发挥更大的作用,并推动 AI 驱动的各类新解决方案的发展。

AI Agent 之风,吹向 Web3

迈出实验室,AI Agent 和 Multi-Agent 道阻且长。

暂且不论 Multi-Agent,即便是当下最先进的单一 AI Agent ,其需要的算力资源和计算能力在物理层面仍有明确的上限,无法做到无限扩展。一旦面临极其错综复杂、计算量密集的任务,AI Agent 无疑将会遭遇算力瓶颈,性能大打折扣。

再者,AI Agent 和 Multi-Agent 系统本质上是一种集中式的架构模式,这决定了它存在着极高的单一故障风险。更重要的是,OpenAI、微软、谷歌等公司基于闭源大模型的垄断商业模式,严重威胁独立、单一的 AI Agent 创业公司的生存环境,使得 AI Agent 无法顺利利用庞大的企业私有数据来使它们变得更聪明、更有效率。AI Agent 之间亟需民主化的协作环境,使得真正有价值的 AI Agent 得以服务更广阔的需求人群,为社会创造更大的价值。

最后,虽然与 LLM 相比,AI Agent 更贴近产业,但其发展基于 LLM,而当前大模型赛道的特点是技术门槛高、资金投入多、商业模式尚且发展不成熟,AI Agent 通常很难获得融资以持续更新迭代。

Multi-Agent 的范式是 Web3 助力 AI 的绝佳角度,已经有不少 Web3 开发团队正在这些方面投入研发提供解决方案。

AI Agent 和 Multi-Agent 系统通常需要大量的计算资源来进行复杂的决策和处理任务。Web3 通过区块链和去中心化技术,可以构建去中心化的算力市场,使得算力资源可以在全球范围内更加公平和高效地分配和利用。Akash、Nosana、Aethir、 IO.net 等 Web3 项目可以对 AI Agent 决策和推理提供计算能力。

传统的 AI 系统往往是集中式管理,导致 AI Agent 面临单点故障和数据隐私问题,Web3 的去中心化特性可以使得 Multi-Agent 系统更加分散和自治,每个 AI Agent 可以独立地运行在不同的节点上,自主执行用户提出的需求,增强了鲁棒性和安全性。通过 PoS、DPoS 等机制建立针对质押者、委托者的激励惩罚机制,可以促进单一 AI Agent 或 Multi-Agent 系统的民主化。

在这方面,GaiaNet、Theoriq、PIN AI、HajimeAI 都有非常前沿的尝试。

-

Theoriq 是一个服务于“AI for Web3”的项目,希望通过 Agentic Protocol 建立 AI Agents 的调用和经济系统,普及 Web3 的开发和许多功能性场景,为 Web3 dApp 提供可验证的模型推理能力。

-

GaiaNet 以节点为基础的 AI Agent 创建和部署环境,以保护专家、用户的知识产权与数据隐私为出发点,抗衡中心化的 OpenAI GPT Store。

-

HajimeAI 则在两者基础上发力 AI Agent 工作流在实际需求中的建立和针对意图本身的智能化、自动化,呼应PIN AI提到的“AI智能的个性化”。

-

同时,Modulus Labs 与 ORA Protocol 分别在 AI Agent 的 zkML 和 opML 的算法方向取得了进展。

最后,AI Agent 和 Multi-Agent 系统的开发和迭代往往需要大量的资金支持,而 Web3 可以通过前置流动性的特点帮助有潜力的 AI Agent 项目获取宝贵的早期支持。

Spectral 和 HajimeAI 均提出了支持发行链上 AI Agent 资产的产品构想:通过 IAO(Initial Agent Offering)发行代币,AI Agent 可以直接从投资者获得资金,同时成为 DAO 治理的一员,为投资者提供参与项目发展和分享未来收益的机会。其中 HajimeAI 的 Benchmark DAO 希望通过众筹加代币激励的方式,将去中心化的 AI Agent 评分和 AI Agent 资产发行有机结合起来,打造 AI Agent 依托 Web3 融资和冷启动的闭环,也是比较新颖的尝试。

AI 潘多拉魔盒已然开启,置身其中的每个人既兴奋又迷茫,热潮下是机遇还是暗礁,无人知晓。如今,各行各业都已不再是 PPT 融资时代,无论多么前沿的技术,也只有落地才能实现价值。AI Agent 的未来注定是一场漫长的马拉松, 而 Web3 正确保它不会在这场竞赛中黯然退场。

对话交易员Jackson:如何真正通过AI+数据捕获Alpha?

本期嘉宾:Jackson,Scope Protocol 联合创始人,推特

TL;DR

1. 不同类型的资产、不同的持仓策略,你需要关注的数据有哪些?

Jackson 将自己的资产分为三种类型,不同类型的资产有对应的持仓策略和要关注的数据,很有意思的是他按照持仓时长来划分资产类型:

长期持有的资产(比如 ETH SOLANA 等主流币)。关注的数据:整个行业目前的流动性情况,有三个指标:

-

美股市场或者美元加息/降息

-

稳定币的 Mint/Burn

-

大 VC 的大额代币持仓

除此之外,非数据层面会关注“叙事”,一个代币是否是被 Top VC 认可,或者 Vitalik、Binance 比较喜欢的资产,决定了是否会长期持有。

-

持仓一周左右的资产(市值 200-700),收益预期每周 10% -20% 。关注的数据:能够反映操盘手习惯的一些异常数据,然后做交易。比如 DEX 超买连续触发了 3 次到 4 次之后,基本上代表了很明确的上涨趋势,可以追涨,实测测下来绝大部分 CMC 上排名 200-800 名,且能够上主流交易所的代币,一周的胜率在 80% -90% 。

-

持仓 4-12 小时的资产,回撤可以接受到 50% 以上,杠杆会开 5-10 倍。关注的数据是短周期能反映情绪变化的指标,有 3 个:

-

Open Interest,市场当中的合约的持仓量。基本上从回测数据来看,Open Interest 大于之前 1 小时 6% ,然后价格如果跌了 4% 的话是比较正面的指标,一般会认为已经下探到阶段性低点,或者空头需要回补。这种时候 4 小时的胜率较高。但具体情况需要具体分析,可以查看 scopechat 上展示出的回测数据。

-

Funding Rate

-

CEX Deposit,这个数据如果发生了特别异常的变化,比如说当前的充值的数量是上一周或者上一个月的 10 倍以上,那么它几乎是必跌的。原因是一些大的、合规的做市商不会在 CEX 里面长期存做市的代币,一般有动作的时候,会从链上再把代币充进去。

2. 不同的数据产品都有什么用?

分为 4 类:

第一类,宏观数据类产品,例如 Glassnode,分析大户的持仓以及流动性的变化,面向围绕 BTC 去做交易的人,或者说想要看到基本面的变化的人。

第二类,通过数据做舆情/情绪分析(分析文本)的产品,例如 Kaito,分析整个市场当中大家在讨论什么,一些所谓的 smart investor 追踪了什么样的产品,面向研究员,比如说 VC 里面要写报告的投资经理,帮助找到什么样的叙事或者基于这个叙事哪些产品可能会火。

第三类,分析链上数据的产品。例如 Nansen,ScopeScan,DEX Screener,DeBank。链上数据其实在这个周期发生了变化,上一轮周期的时候,我们会通过 Gas 的消耗的高低来判断哪些产品接下来会火,而这个周期链上数据围绕在短平快的 Alpha,比如说 Solana 和 Base 上的 MEME,这些代币能够产生的数据丰富度弱了许多,因此更新频率、上币速度、解析速度特别快产品会更有优势,比如 DEX Screener。另外,如果是希望追踪某一个地址多链的数据情况,进行深度分析,DeBank 是最佳选择。

第四类,满足调查类需求(吃瓜)的产品,例如 Arkham,分析一个地址背后是谁,持仓的具体的情况,最高的胜率发生在什么情况下。这个产品的标签做得很多,但是准确度存疑。

3. 不知道买什么和要买吗的时候怎么办?

Jackson 认为,对于普通用户来说,通过数据来辅助交易是很难的,一方面是数据噪音很多,另一方面数据分析和使用的门槛略高,所以他的产品希望给“没有太多时间研究、没有特殊的交易天赋”的“普通交易者”相对傻瓜式的服务,有两个典型场景:

第一个,买什么?这里面不同的细分需求有不同的设计:

-

Copy Trade 的需求

-

如果想要交易一些较为主流的代币,最有效的是 Copy Trade VC-related address,可以直接在 Scope Chat 里面问,目标 token 的持仓结构,会给你一张有 VC 和巨鲸持仓的表。

-

如果想要 Copy Trade 类似于 MEME 的 Alpha 资产,可以在 rank 里面去找 smart money 究竟在卖什么。

-

投资 Beta 资产的需求,这种人更相信叙事,相信注意力,可以参考两个 Rank:

-

Narrative Rank,可以看到大家比较关注的细分 narrative 是什么,基于 narrative 缩小了研究范围之后,再去单独的看 Token 是不是应该交易。

-

注意力 Rank,即 3 万个 KOL 每天在讨论什么 Token 也被做成了一个 rank, 本质上就在捕捉市场的注意力是什么。如果这些东西你都不看的话,可以参考分数,这个分数代表的是 AI 通过信号判断的接下来 24 小时某个代币有可能会涨还是有可能会跌。

第二个,知道了一个币,要买吗?

这个场景下可以有两种操作:

-

直接问 AI,Can I buy XXXX today?AI 会给你一个既有 bullish 也有 bearish 的综合分析,你可以进一步分析来判断是否交易。

-

在产品上搜索代币,查看大家的观点,观点总结了所有的 KOL 和新闻媒体对这个代币的讨论、报道。每一个 KOL 的胜率也在产品里面标注,一个人的胜率越高,证明他的这个回答越有参考价值。

4. 如何使用工具提高交易胜率?

以 0xScope 举例,Jackson 的每日 Routine 大概是:

第一步,查看现在比较火热的叙事,然后在选定的具体叙事里筛选相对来说还没有补涨或者一些其他情况的资产。

第二步,点进资产查看 Trading Signal 的页面,里面详细的写清楚了,不同类型的 Signal 跟代币价格的关联性及不同时间范围的胜率,选择可以接受的胜率,再确认资产本身的流动性 OK,设置一个预警。

第三步,下一次有这种信号异常情况出现的时候会报警,这时候填写一个备注,比如 PEPE 需要关注的是 Open Interest 这个指标,之后根据原来既定策略去开工。

5. 下半场我们买什么?Party Game Token

Party Game 的特点是:

-

涉及到了新的资产的发行;

-

是一个生态系统,party 里面的成员有很大的动力去通过除了直接卖币之外的其他手段去获利。

如果外部的流动性有正常的输入,比如降息,会更多的关注这种新的 Party Game 里面的资产,具体举例就是 Monad 和 AI 的 Infra。

欢迎大家去试用@ScopeProtocol。

采访原文

FC:

想做这期的背景挺简单的,就是说实话我一直不知道两个事情,第一个数据有什么用?第二个这么多工具我应该怎么用?看到挺多工具,比如 Nansen,包括我们自己投的 Footprint,其实挺多,到底怎么用有什么用,这个事其实想一次就聊明白,所以就找到你了。

而且我觉得听过你之前的分享,你其实也在用你自己的信号其实去做一些交易,这次来想让你把工具和数据讲清楚。我之前在 36 氪的时候,我们当时主要做一级市场的数据,那个时候大家在意的主要是两个功能,第一个叫做趋势的变化,比如通过各个指数来分析意向融资赛道的趋势变化,这个是所有 VC 都特别想看的。但是其实一级市场会比较慢一些,慢的好处在于说别人也没比你领先多少,对交易其实影响就不大,所以当时那个数据是不能收费的。第二个我觉得有用的是叫做观察仓,就是你的 portfolio 有什么异动了,他们作为投后其实很需要,我知道你们也做这么一个功能,我认为这个事是一个不挣钱的生意,要花很多时间和人工来数据清洗。

所以我觉得要么这样,你可以大概介绍一下你自己的背景以及现在做的事情,然后我们开始往下的一些关于交易的话题。

Jackson:

可以的,这个非常 FC 邀请我加入这次这个活动,之前的几期我也都听了,大家都是非常专业的交易员,相比于他们来说,我可能并不是非常专业背景的交易员,但是确实已经入行差不多有 7 年的时间了,在 2 年之前的时候做了0x Scope 这家公司,基本你可以理解为它是一个数据公司,我们覆盖的数据类的产品线还是很多的,不只有给机构端提供的 Scope VC 这个产品,也有一些专注于链上数据的 Scopescan 这样的产品,还有给开发者做的 Scope API。最近半年的时间做了一个 AI 产品,叫做 Scope Chat,这个 Scope Chat 就是非常偏交易导向的一个产品了,这个产品的目的就是希望大家能够在最短的时间内做出胜率最高的决策。所以最近的这半年时间,我才花了很大的心思在交易这个方向,也在一直在寻找怎么样用数据来辅助交易,怎么样在这个数据当中能够提高你的交易策略的胜率。

我自己在做这个项目之前,也一直在区块链行业里面。几乎你能想到的 Crypto 产品类型都做过,Layer 1、Layer 2、交易所,一直是一个产品经理。开始做数据之后,我也一直秉持着做产品经理的这个思路。作为一个产品经理,有一句话叫屁股决定脑袋,但作为产品经理你是永远不应该有自己的屁股的,你的屁股应该坐在用户那里。所以从做数据开始,不管我们做什么类型的数据,服务于什么样的客户,基本上我给自己的宗旨都是希望能通过客户的角度去想问题。所以最近半年我们在做交易的时候,确实也思考了很多,也想了很多,今天也非常荣幸有机会能够跟大家来做一下分享。

FC:

感谢。其实我对你印象特别深,因为我听了你的分享里面很多都是跟场景相关的,比如说兄弟们吃饭,问你别人推荐一个币你应该怎么办,我们一会儿在下一个环节的时候具体说说你的产品。先说你的交易策略,如果你用一句话来总结你自己的交易策略,你是一个什么样的策略?包括你自己的一个交易风格是什么样?

Jackson:

我自己的交易风格是风险偏好很低,又特别忙,也不是一个什么很聪明的人,反正你可以理解为我的交易策略比较适合于像我一样大部分 I Q1 00 ,平时风险偏好又比较低的人。大仓位来自于我自己所做的研究,中小仓位来自于我自己所做的数据以及这些数据和反馈给我的一些 Signal。

FC:

我理解其实说 I Q1 00 其实大家就是在搏一个叫 Smart Beta,是吧?

Jackson:

差不多,对 Alpha 我觉得胜率太低了,可能会有,但是对我来说自己的交易策略还是在搏 Smart Beta。

FC:

明白,你能大概说说你的预期收益和说有没有止损线?或者交易策略我理解是你的资金规模,你的预期收益?还有比如说你的风控?当然你可以不说多少钱,可以说关于整个交易策略的详解。

Jackson:

我现在基本上个人 60% 左右的仓位是在一些主流的资产上面,ETH、SOLANA 这些。一些新的天王级项目之前我买过比如 ARB,但后面我都全卖了,这个的逻辑主要是 Long Crypto。然后 30% 左右的资产,会去买一些适合持仓一周左右的资产,为什么我要说这个时间呢?主要是跟我们本身做的这个产品有关系,一周左右的资产我可能关注的数据指标会不太一样,可能会关注一些偏趋势类的指标。还有 10% 左右的资产,我会玩一些 4 小时到 12 小时左右资产,这些资产我可能会关注比如说 Open Interest、Funding Rate,或者说是及时的一些新闻,一些安全的事件,一些大额的冲提的异常数据。这一部分的资产,我甚至可能会做一些合约相关的这种操作。

不同类型的资产我可能止损的节奏是不一样的,比如说大的仓位,我基本上只关注于分析整个市场的流动性。30% 左右的资产,我可能的收入预期是每周差不多要在 10% ~ 20% 左右, 10% 的这个 4 小时到 12 小时这个资产,我的回撤可以接受到 50% 以上,甚至更高,但是这个收入的预期我肯定就要把它做得更好,一般杠杆会开 5 ~ 10 倍左右。

FC:

我想知道你这几种持仓时间,你整个决策路径是什么样的?比如说我认为小时级别的可能看数据,长期的你会怎么做?我想听听你的交易的决策过程。

Jackson:

其实不同类型的资产,它可能就是不同类型的持仓策略,它要看的这个数据是不太一样的。比如说长周期的 60% 的主流币的仓位,我基本上只关注整个行业目前的流动性情况,它是整体的有流动性输入还是有流动性输出,这个数据就比较常见了,比如说整个美股市场或者美元有没有加息、降息的这种趋势,这些其实我自己是不懂的,所以我基本上都去看别人的一些分析,看大家整体的这个意见是什么样的。要么我们就会看一些稳定币的 Mint 和 Burn 的情况,或者看一些大的 VC 的一些大额代币本身的持仓情况的变化,这些都是比较偏基本面的。

持仓一周左右的资产,我会重点关注的是那种有点像我们所理解的这种叫逆势策略,什么意思?我一般投资的这种类型的仓位是那种差不多市值在 200 ~ 700 左右的代币,这种代币它在某一个阶段之后,你会发现它背后可能有明显的操盘手。所以这种持仓一周左右的资产,我的目的是希望能够通过数据去尝试捕捉,能够反映操盘手习惯的一些异常数据,然后做一些逆势交易。比如说我们最近实测过的几个数据是比较有用的,链上的数据大家有的时候可能觉得没用,甚至有的时候你会发现 DEX 跟现货 CEX 里面交易量差别还是有点大,但是链上的好处在于链上老鼠仓很多,老鼠仓很多一般体现在 DEX 买入的一些异常数据之后,你会发现如果你对比上一周或者上一个月的这个数据,突然在这一周的某几个时间节点,在 DEX 上面有异常的超买,那么这些异常超买有很大的概率是操盘手自己的老鼠仓。这些超买最终又会充值到交易所当中,但是这些代币的充值,一般情况下会引起现货价格的降低。但是如果他过了一段时间发现这个代币的价格并没有降低,甚至 DEX 超买它连续触发了 3 次到 4 次之后,我们大概率认为它可能就是一个能够反映操盘手异常数据的一个指标。如果它能够连续触发 3 次到 4 次,我现在测下来绝大部分的 200 ~ 800 名左右的代币,能够上一些相对比较主流的这些交易所的代币,它一周的胜率基本上都在 80% ~ 90% 。我现在说的所有的数据在我们的 Scope Chat 产品上都可以看到,如果大家不相信,可以自己去看一下,再去自己去算一下,这个是一周左右的这些信号。 然后说 4 小时到 12 小时,这个就是一个非常短周期能反映情绪变化的指标,可能只有几个是有用的。第一个是 Open Interest,就是市场当中的合约的持仓量。第二个是 Funding Rate。第三个是 CEX Deposit,这个数据如果发生了特别异常的变化,比如说它当前的充值的数量是上一周或者上一个月的 10 倍以上,那么它几乎是必跌的。我可以举个例子,上个月的时候我赚钱可能比较多的一个仓位,那个仓位它是一个社交类的代币,它因为一个大佬的参与在社交媒体上讨论度很高,我们提前抓到了社交媒体讨论度的上升,但是那天没买。到第二天的时候代币价格已经涨了很多,我突然发现它有一笔超过 20% 的 CEX Deposit,来自于他们做市商,这个做市商我们之前也研究过,它内部有非常严谨的操作流程吧,所以他不会在 CEX 里面长期存做市的代币,一般有动作的时候,它会 on chain 再把这个代币充进去,所以我看了那个单子之后,我就开了一个空单,果然就跌了很多。

这个就是不同的持仓周期的代币,我会看什么样的数据。

FC:

咱们再具体说一下,它相当于是在交易所存币了还是借币了?

Jackson:

存币,就是 CEX Deposit。我其实之前也很困惑,因为理论上做市商可以把他持仓的客户资产一直放在交易所里面,然后不动,这样他任何的一些操作实际上大家是看不到。

FC:

你的意思他给托管了,对吧?

Jackson:

对,他应该是托管的。但是我发现几个很大的、很合规的做市商,有这种动作的时候,它要砸盘的时候,他会从 on chain 把钱充进去。这一套流程完了之后,他又会提出来放在 on chain。后面我去问了几个做市商,其中一个做市商告诉我,人家内部就是有这个要求,所以我有时候觉得这个也挺奇怪的,但是最终其实在数据上面它都有体现。我们产品现在你能够看到回测的数据,出现类似这种情况之后,它的胜率是怎么样的。我们发现越合规的做市商类似行为的胜率越高,反倒是一些链上动作不够频繁的做市商,他可能就比较黑盒了。

FC:

理解了。我听你提到之前持仓 ARB 但后来卖了。为什么卖了?跟你的数据角色有关吗?就你这种比较长周期的仓位。

Jackson:

长周期的仓位我基本上除了用数据去看一些基本面的情况之外,比如说流动性,跟数据我觉得没有什么太大的关系。 如果抛开流动性之外,一些可以持仓长周期的东西,它基本上跟叙事,跟所谓的能够引领 attention 的这些人或者机构,他们想要推动的 narrative 有关,所以我基本上是靠对产品本身的研究,去判断我应该去持仓什么样的代币,然后怎么样去进行交易。我会去判断接下来某一个代币可能是 Top 的 VC 或者机构他认可,或者 vitalik、binance 比较喜欢的资产,我可能才会去比较长周期的持有。如果这些都没有的话,那对我来说风险可能就太大了。之前我一直认为 Layer 2 是一个很不错的能够解决 ETH 扩展性问题的一个场景,后来慢慢的发现其实大家对 ETH 好像并没有那么忠诚,甚至有点分散,所以我就卖掉了。

FC:

明白。假设我们现在要关注 Layer 1 ,我不知道这个是不是在你们做的范围之内,关注 Layer 1 可能有一些维度,比如像之前 Sui 拉盘之前,它的 TVL 大概涨了 2 ~ 3 倍。像这种比如以月为跨度,或者说以赛道为跨度的数据,你们有去在做吗?或者你认为这些数据,哪些维度会影响交易?

Jackson:

我是觉得不管是 TVL 还是 DAU 的这些数据,它的造假成本太低了。因为我们0x Scope 的第一年是做了 Scope Scan 这个产品,它最大的一个特性是我们有一个算法可以算出哪些地址可能属于同一个人,通过这个功能我们发现,实际上市场当中大家能够看到的一些跟项目基本面相关的数据里面的水分实在是太大了。我可以给你举几个例子,就是有几个链,有几个当时还比较知名的链上面几个头部的项目,它的水分以我们一个深度学习的很基础的算法,就能够排除出差不多 95% 的 fake traffic,就是他可能 100 万用户里面有 95 万的用户可能都是假量。所以我经过那一年的数据的分析,看到了很多很 deep 的数据之后,我觉得这种东西里面的造假的难度其实也很低,造假的情况出现的也太多了,所以如果你让我自己去交易,我永远吃不准,我不知道 TVL 是不是来自于几个人攒了个局。其实你也可以看出有很多链它的 DAU 一直很高,但是这几个链上有什么火热的项目,其实没有。所以我自己其实很久不看这些数据了。

FC:

我还有一个比较关心的问题,比如说你们肯定去做一些竞品调研,或者你肯定是现在对这个市场有理解嘛,因为你做之前应该是有 Nansen 的对吧?

Jackson:

对,我其实做这个产品的契机也挺有意思,我其实之前被 Nansen 标记过 Smart Money。在 LUNA 爆雷之前,我有套利的几个策略,其中一个策略是套利做多,另外在 CEX 里面有做空,它可能是一个套利策略,但是 Nansen 把我的胜率比较高的地址就标记成了一个 Smart Money 有一段时间。后面我们有同事跟我说过这个事情之后,其实我发现了一个点,on chain 的地址它是没有 KYC 的,所以如果你以 single 作为数据分析的基础单位,里面的噪音就会非常大,所以我就有了一个 idea,希望通过知识图谱解决这个问题,把数据分析的最小单位从 single 变成一个 entity,理论上我们实现了一部分,后面又发现了可能整个行业大家都是这样的,所以我们就开始转到一些其他的方向上面去了。

FC:

明白,我想问的问题是说在你眼里比如数据产品分几类,它分别都对应着什么样的交易策略的人可以用?或者说它分别对应着是为谁设计的产品?

Jackson:

首先最大的就是宏观数据类产品了,比较常用的 Glassnode,我看倪大就经常在用这个。因为 Glassnode 对 BTC 以及 BTC 生态的那个数据做的是很好的,可以分析一些这种大户的持仓,流动性的变化,所以可能围绕 BTC 去做交易的人可以用 Glassnode,或者说你要通过 Glassnode 去看到一些基本面的变化,是一个还不错的产品。

第二类就是你要通过这个数据去做一些舆情的分析、情绪的分析,比如说像 Kaito,它本质上是一个大语言模型加搜索引擎的一个架构,在 AI 里面我们把它叫做 RAG。RAG 它对文本的数据处理其实是很有帮助,其实我们的 Scope Chat 也能查到一些文本的数据,也做了一些推特的分析,但 Kaito 在这个方向可能做得更好。这些类型的数据它比较适合研究员,比如说 VC 里面要写报告的投资经理,因为 VC 很大情况下他的工作的重点是要判断趋势,要帮助我这个机构找到可能什么样的叙事或者基于这个叙事哪些产品可能会火,大家可能会通过这种针对文本数据去做分析的产品,去判断整个市场当中大家可能在讨论一些什么样的事情,一些所谓的 smart investor 在讨论一些什么样的东西,或者说是一些所谓的 smart investor 去 follow 了什么样的产品。我觉得如果你有这种需求,可能用 Kaito 这样的做情绪分析产品,我觉得是不错的。

还有一些人会用像 Scope Scan 或者 Nansen 这样的 on chain 产品。虽然我也做了一个类似 Nansen 这样的产品,但大家其实也可以看到 Nansen 的流量是一直有下跌,我们 Scope Scan 的流量诚实说也一直在下跌,我觉得这个很重要的一个原因是这一轮跟上一轮周期不同的是,这一轮周期 on chain 上面的数据丰富度弱了很多。这轮周期上面 on chain 的数据可能没有一个所谓的中间态,它围绕在那种特别短平快的这种阿尔法,比如说 Solana 和 Base 上的 MEME Coin。这些 MEME 它能够产生的数据可能就只有那几类,导致它整体的门槛很低,最终用户对这类数据的需求会转移到那些更新频率特别快,上币的速度特别快,解析速度特别快的一些产品,比如说像 DEX Screener 这样的一些产品当中去。

还有一类是偏调查类的需求,比如说你就想知道这个人他背后是谁,或者说这个人他的持仓的具体的情况,最准的这种情况是什么?很多人就会用像 Arkham 这样的产品。因为它的标签确实做得很多,但是准不准我们存疑。如果你是调查需求,要去吃瓜,我觉得 Arkham 是很有用的。

如果你想要对你 follow 的某一个 address 有一些深度的分析,去看它的持仓,看它多链的数据的情况,DeBank 在这方面其实是做最好的。虽然都是竞争对手,但我这个很诚实的说,DeBank 在这方面确实是做最好的。

所以在 on chain 的数据里面,你会发现它很少有像以前一样的中间态。像上一轮周期的时候,我们还会关注那种谁的 guest 消耗比较高,我们就能看到哪几个 gas 背后的合约地址它代表的项目是什么,我们通过项目的分析判断去找到哪些产品可能接下来会火,我们提前去研究这个产品,去参与它的 DeFi Summer 或者其他类似的一些动作,但在这个周期这样的东西很少,这个是 on chain 的数据的一些情况。

那我们在做一件什么样的事情?做了这么长时间的数据之后,我们慢慢发现数据类的产品其实它有一个很大的问题,就是这里面的噪音或者影响的因素太多了。除了吃瓜之外,或者说你自己要做一些非常 deep 的这种分析之外,其实它对普通用户来说,我觉得属于那种看个热闹的这种程度。我看了很多那种媒体他们也转发我们所 post 的一些东西,但这种东西对你的交易本身有用吗?我觉得大部分人其实没有把数据真正的反馈到自己的交易体系上来,主要的原因就是数据它噪音很多,不同 Token 它对应的数据指标,可能你需要因地制宜的分析,case by case 的去分析,这就实际上导致了如果你要用好数据,它的成本是很高的。所以你就会慢慢的发现只有一部分 Degen,还有一部分 VC 的 investor,他们平时对数据的需求是很高的。

Degen 他可能去研究数据,去看他要冲的那几个土狗的老鼠仓是谁,没有安全的风险,看完之后,这个赌性比较大的地震可能就直接冲了,冲完之后就各凭天命 PVP。研究员就去看情绪的分析,看 smart follower,有几个美国的机构 follow 了几个粉丝 2000 以下的项目,我抓紧 follow 一下 dm 一下,看看能不能要点额度。最终你会发现大家对数据需求,实际的使用需求就变成这两类,我们后面就做一次测试,我们出了一个 AI 产品,让大家随便去问,最终我们发现普通的散户的问题就两个,一个是买啥 oken?另外就是这个 Token 能不能买?我觉得这个其实也很有趣,我就一直在想我们要怎么样把分析数据的门槛打下来,让更多的人能够通过数据辅助交易,后面在大语言模型出来之后,我觉得这个事情应该是可行的,所以我们现在做的事情是什么?我不直接给你那种什么 CEX 充了多少量,某一个 smart moeny 的地址,他又买了什么代币,或者说就是你要打开 etherscan 不断的查看谁是最先买的,这个人卖了没有,类似这样的一些数据。我把不管是链上还是链下的数据,有可能会影响价格的数据,都通过深度学习的算法先把它筛出来,筛出来之后,再把这些数据的异常值报给用户。我们的产品上面报给用户的最重要的点,我们把它叫做 smart signal,如果这个 signal 报给你,你觉得它是异常的,我又给了你这些 signal 跟之前的一些这种实测的数据,如果你相信我们,你觉得这个事情胜率高,你就去跟单。

你跟的其实不是某一个 smart money,有可能这个 smart money 它并不 smart,你跟的是这些异常的数据信号,如果你对这个异常数据信号很感兴趣,我们的产品上面也提供你再去做深度的分析,这样子其实我们就能够解决一些普通的散户,这些人可能都跟我一样,没什么时间,又没有那种超凡的天赋,超高的智慧,我们可以通过一个 smart signal 来提醒你,其实你的胜率我觉得就会显著的提升,因为我们自己测下来确实用了这个产品之后胜率会显著提升。

FC:

你们一般是怎么用的?比如说你们的产品怎么用能提高胜率?

Jackson:

其实很简单,大家可以看我们之前做的一些分享。我一般是这样子,每天早上去看一下现在比较火热的 narrative 是什么?你打开那个产品里面有一个火热叙事的那一栏,这一栏里面会根据大家的讨论度,叙事本身涨幅情况去看看有哪些好的叙事。叙事选完之后,我自己常用的一个策略,可能哪个资产是相对来说还没有补涨或者一些其他情况的这种资产,我点进去资产里面,就能够看到一个叫 trading signal 的页面,里面详细的写清楚了,不同类型的 signal 跟代币价格的关联性是什么?它的胜率怎么样?它 4 小时的胜率怎么样, 12 小时胜率怎么样? 7 天的胜率怎么样?我一旦发现哪个胜率对我来说是我可以接受的胜率,比如说 70% 我可以接受,这个资产本身我觉得它流动性也还可以,它没有一些什么幺蛾子的这种异常情况,那么我就会设置一个 alert,设置完 alert 之后,它就会在下一次有这种信号异常情况出现的时候报警,报警完的时候我 alert 里面我可以填一个备注,里面我会写清楚,比如说 pepe 是个代币,我自己常关注的就是它的 open interest 这个指标,我发现它的 open interest 有异常值的时候,就会给我报警,报警完了之后我再根据我原来既定策略去开工。

FC:

理解。我不知道你有没有看到一个视频,就是二宝他们在一个 AI 上面预测比特币的好像是哪一年的价格要到 19 万美金还是 100 万美金。我想问的问题是,这种所谓的 AI 预测长周期的,我觉得他商业模式特别有意思,就是因为他拿那个视频引流,引流以后,他最重要的收费的点是预测价格,预测一次 3 U。我觉得商业模式其实挺好的,就是他挺容易骗大家过来去买这 3 U 的,你知道。所以我想知道,从你的角度看,像这种长周期的预测,第一你认为准还是不准的,第二你认为它背后的逻辑是什么?以及我们应该怎么去看待这种所谓 AI 给我们带来这种预测?

Jackson:

我觉得 AI 它的其实预测逻辑其实很简单,你给 AI 喂一些,关于 Token 过往的一些技术指标,比如 MACD、EMA 等等,大语言模型他会给你一个比较 general 的逻辑上面的判断,比如说一般出现了金叉,或者出现了死叉的情况下,它的走势会是什么样的?我觉得大概率你所说的这个东西它可能是这样的逻辑。

实际上这个东西我们把它叫做指标交易,这个指标交易一定程度上是在通过现在发生的一些异常的指标去判断整个代币它未来走势的趋势是什么。我可以举一个例子,一般在我们的产品里面发现 dex 的超买,连续发生三次左右,这个胜率就一下子会从 60 多涨到了差不多 70、 80 甚至 90 对吧?甚至它还会再一直涨。实际上这个逻辑有点像追涨。你发现市场当中代币可能已经涨了 1% 或者涨了 2% ,如果你现在再追涨,它大概率还会再涨到 8% 或者 9% ,类似这样的情况,它本质上就是一个通过异常情况发现了某些趋势会发生,你追涨进去或者杀跌进去的。我一定程度上认可这种方式,但是这种方式你必须再有大量的不同类型的可以反映这个趋势的数据的基础上,它才可能会有效。比如说一开始我们在做这个产品的时候,也只有一些所谓的技术指标,但是并不是所有的代币都适用这种技术指标的,只有一些流动的特别好,没有那种野庄的代币,才可能比较符合这种技术指标。

但是大量的快速的代币,它可能背后都是几个野庄,骚操作很多,但是这种骚操作一定会留下一些痕迹,而这些痕迹有可能是链上的,也有可能是链下的,我们通过回测抓到了这几个异常数据,有可能就是他们留下的一些痕迹,到接下来我们顺着痕迹再去做交易的时候,至少它在三个月的周期里面大部分还都是持续有效的。所以总结一下来说,一定程度上我觉得它是有可能实现的。但是实现的逻辑其实就是我们通过数据去捕捉 Token 未来涨跌的所谓趋势,你要让趋势的捕捉更有效,这个比较好的办法或者比较实在的办法,就是你一定要覆盖掉更多可能性才 OK,在这个方面我们真的是费了非常大的精力。

FC:

所以就是要素要足够多,首先你要基本上 cover 尽量多的可能性,再从里面挑相关性。

Jackson:

是的。

FC:

假设我们就用数据去做交易,我们应该注意它的风险,或者它可能出现的失效的情况是什么样的?

Jackson:

其实我觉得这个都是 case by case 的,但是这也是做数据的一个好处,就是实际上我们对所有指标的要求是至少要回测 180 天,然后提供给用户有效的数据,只有最近的 30 天、 60 天还有 90 天左右的。一般情况下我觉得某一个指标在 30 天左右甚至两个月左右,它就有可能因为市场情绪本身的变化就失效了,所以你往前回测的范围越大越广,那么你能够覆盖到的同类的可能性,我觉得可能是更高的,我不能拍着胸脯说这个东西一定是 work 的,但至少通过我们的测试,以及首先是我们的回测,但是回测它有一定程度的这种过拟合存在,我们想了很多的办法,但是现在我们实测下来,大部分的指标至少在一个月到三个月左右还是有效的,如果它的市场环境发生了很大的变化,那么这个时候可能一些另外的指标会发挥作用。

FC:

明白。我记得比 Nansen 上面其实有一个叫做代币趋势,有一个国外的用户,具体名字不记得了,他大是怎么看 Nansen 的?第一看整个交易量趋势的变化,第二个看交易量和谁玩(交易)了,比如说这里面有 6 个他认识的,KOL 或者是 Smart money 加上池子的深度 OK,他认为大概率这个事儿可能还不错,就进入他的初筛,初筛以后他就去看 Twitter,看题材,看内容,他觉得也还不错,那可能在一个小时之内做一个判断就梭进去了。之前我听你的分享,其实你在设计产品的时候有一个特别有意思,我觉得你对场景特别敏感就在这。你会说比如现在我们在 bar 里面喝酒,朋友说你去买一个 token,一般以前会说你这靠谱吗?或者你给我说个理由,可能现在就是你告诉我一个币,在 Scope Chat 里面一搜,它会告诉你大概的一个逻辑,靠不靠谱,我不知道你在设计的时候还有哪些这种场景?或者是你自己是有一些假设的,让大家可以去使用的?

Jackson:

其实我们总结下来就几个场景:

第一个,用户不知道要交易什么 token 的时候,你得给用户提供一个选择,一套方法论来教他要怎么选择,所以我们把排行榜设计成了几种类型,比如说 copy trade,就 copy trade 的这种需求,一般情况下,如果你要交易一些较为主流的代币,我们发现的最有效的数据,是你去看一些 VC 他的持仓变化。这里面还有一个挺 tricky 的事情,就是我们的产品,有两种 VC 的 label,一种是 VC 它披露出来的 label,一种是 VC relative label,有好多比较大的资产,尤其是排名前 100 的资产,VC 披露的这些地址是常持这些资产的。一些 relate 的,就是卖这些资产的概率非常大。假如你现在听到了很多这种 Layer 1、Layer 2 ,基本上可能都是他们减持的范畴。我觉得这里面你们能发现一些所谓的趋势,最好去 copy trade 的一些所谓 VC relate address,这个东西你要怎么查?你可以直接在 Scope Chat 里面问,你想要交易的 token 的持仓结构,我们会给你一张表,这个表里面就有 VC 的持仓,巨鲸的持仓。如果你要 copy trade 一些所有的这种阿尔法资产,meme 这种,你就在 rank 里面去找 smart money 究竟在卖什么。还有一种人他也是投资 Beta 的资产,他可能是投资人背景,更相信叙事,相信注意力,这种人我们给他的两个 rank,一个是 narrative rank,我们把 narrative 分得非常细,AI 就分成了 AI Agent、AI MEME 等等各种各样的 rank,你通过 rank 可以看到大家比较关注的 narrative 是什么,基于 narrative 缩小了你的研究范围之后,再去单独的看这些 token 是不是应该交易。还有一个就是我们把 3 万个 KOL 每天在讨论什么 Token 也做了一个 rank, 本质上就是在捕捉市场的注意力是什么,比如说今天就是 TON 和 BLAST 的排行比较前面,但是有的是比较正面的反馈,有的可能就是比较负面的这种反馈了。如果你这些东西你都不看的话,我们还给了你一个选择,直接通过 signal 算了一个分数,这个分数代表的是我们的 AI 认为接下来 24 小时它有可能会涨还是有可能会跌,但是这个是 Beta 的阶段,大家可以信也可以不信,所以这个就是我们自己设定的几个选币的大场景,copy trade 的场景选 token,靠 narrative 或者注意力来选 token 或者直接你就相信我们的信号去选 Token。

第二个,你知道了一个币或者你已经听到了一个币,这种场景下要怎么办?在产品设计上面,首先你可以直接去问 AI,说我能不能买,Can I buy XXXX today?你就直接问一句这样的话,我们的 AI 就给你一个各种各样指标综合的东西,但是这个东西有点像既可以买又可以卖,因为我们需要给你一个比较全面的分析,它有 bullish 的也有 bearish 的,尽可能的把他的一些好的跟不好的都给你,你自己再去分析是否要进行决策的交易。还有一种情况就是你可能在推特上面看到有人 mention 了一个代币,但是你不确定,因为大家的评价可能都是一致的,那么你可以在我们产品上搜索,点进去之后你会发现有一个大家的观点,这个观点我们就直接总结了,所有的 KOL 只要提到了它,究竟在讨论啥, 24 小时讨论啥,以及所有的新闻媒体是否发了关于它的一些新闻,这里面有很多很有意思的点。我们今天还刚刚发了一个 Twitter,有的 KOL 它的胜率真的很高,过去一个月喊单的胜率有 86% 左右,甚至有几个 KOL,可能我们中文圈比较著名的几个“反指”,我就不说名字了,TA 的胜率反而还挺高的,有一些大家可能比较尊重的 KOL,或者说很多人比较信的这些 KOL,TA 的胜率其实很低。每一个 KOL 的胜率也都在产品里面标注着,你可以直接看到哪些人在讨论这个 Token,这个人讨论的胜率怎么样,他的胜率越高,证明他的这个回答越有价值,如果他的胜率很低,但是发了一长串的话,很多人还点赞或者怎么样,有可能要么是自己刷的,要么可能没什么(参考的价值)。

FC:

了解。其实之前也看到,比如说你也听之前我对话交易员,想知道在过程中你在寻找什么答案吗?

Jackson:

其实我一开始就说了,对自己的定位是那种很忙,没什么时间去深入的进行分析,不是一个所谓的 Degen。另外一点我不觉得我自己是一个聪明人,所以当发现这个 smart signal 比较有用的时候,我就找了非常多专业做量化的人,一些专业的交易员,我去跟他们讨论 signal 本身你们在做量化过程当中是怎么用的,这个东西怎么这么好用,或者说这个东西为什么有的时候胜率这么高,所以像你主持这几次活动,我都有非常认真来听,我是希望听到一些,他们对交易的整个过程的梳理,比如说大家都 mention 到的一个事情,就是所谓的这种情绪传导,你处在情绪传导链路的哪一个位置,代表了你可能能赚到什么样的钱。实际上你做 signal 也是一样的,如果你提前捕捉到这个异常,你可能就在情绪传导的,可能不是最 Top 的那一级,也一定是可能第二级或者第三级了,如果它能传导到 6 级 7 级,那么你大概率还是能够捕捉到一部分的 Beta 的对吧?所以本质上来说我还是希望通过跟不同人的沟通去学习,来证明这个事情确实是有价值的。

FC:

明白。最后有一些成长路径的事情也挺好奇的,假设如果让你选的话,你有没有自己比较喜欢的交易员或者交易风格?

Jackson:

没有什么特别具体的交易员或者交易风格。我们现在已经做到这个程度了,我也可以诚实的告诉大家,我们在尝试做一个基于数据基于指标交易的一个量化策略。前面我也提到了,尤其在一些比较高频这种场景里面,我不太相信自己的判断,也不太相信自己的运气,我做了这么多事情,最终是希望能够有一个基于数据驱动,同时能够捕捉到很多可能别人捕捉不到的数据,再基于这些数据去赚钱的一个所谓的交易机器人,现在我们在朝着这个方向去努力。基于这个方向,其实我们最近密集的跟很多的量化基金在聊,去学习他们的经验,去问他们怎么调整自己的 model 等等这些。

FC:

OK。另外两个问题:第一个,牛市下半场大家可能更关注 AI,还有 MEME,从你们的角度来看,下半场应该关注什么多一些?第二个,如果我们想更好的去用数据去做交易,你推荐我们应该看一些什么样的内容?

Jackson:

第一个问题,下半场要看什么,我觉得跟大家还是比较有共识的点是我们最近一直在讨论一个理论,我最近回到新加坡之后,很多 founder 坐在一起就在讨论 party game 这个事情,尤其是很多华人的 founder 觉得自己加入不了 party game,其实对整个创业很难。如果你说我自己从交易的角度,可能下半场会关注啥,我还是会关注那些大家新攒的一些所谓的 party game,比如说像 Monad,比如说像可能未来会有的一些这种 AI 相关的 infra 可能是我比较关注的,因为我觉得这种涉及到了新的资产的发行,同时它又是一个生态系统,背后的这些 party 里面的成员,他应该是有很大的动力去通过除了直接卖币之外的其他手段去获利,如果外部的流动性有正常的输入,比如说降息,那么如果这种 party game 的逻辑本身还是 work 的话,我会更多的关注这种新的 party game 里面的资产。

第二个问题,从数据上来说应该怎么看,我觉得还是回到之前我所说的,首先判断你自己是一个什么样的交易风格,或者你自己是一个什么样的人。你是一个投资人,那么一些文本类的舆情趋势的数据应该是要重点关注的。如果你对自己很有自信,觉得自己可以变成一个 degen,可以在 PVP 里面胜出,那么你重点需要关注的就是,怎么样找到你所关注的那些所谓的最早期阿尔法资产里面的老鼠仓,基于老鼠仓的动向,再去判断你的进场跟离场的点位。如果你跟我一样是属于平时有一份工作,没有太多的时间去关注整个市场,关注各种各样的数据,没有太多的时间去做非常深入的这种分析,那么你看一些,把整个的这种数据的 Learns,这种信息流,最终能够通过 AI 不断的简化,只关注一些异常的信号,可能会对你的交易帮助更大一点。

FC:

刚才你说 party game,其实最近我一直在思考,怎么去从一个传播的角度来整理,所谓的价值 Token 和 MEME 一个路径的不同,所以我想问问,你认为 party game 里面都有谁?它的元素是什么?谁是组织者?或者说谁是邀请的人?嘉宾又有谁?这个过程是什么样的?

Jackson:

之前不是有 VC 盘跟 MEME Coin 的对比,其实我们后面分析了这个数据,背后都是 party game 的逻辑。当然有一部分 degen 顺应 party game 他可能确实赚到钱了,像昨天 GoPlus 出的那个报告,meme 生态整个浪潮里面赚钱的可能只有百分之十几,大部分人还是亏钱的,而这个 meme 可能用了 Fair Launch,一种让你亏得更舒服的方法,但本质上逻辑是一样的。所以不管是这种很大的新生态的项目的 party game,还是一些跑出来 Meme Coin 的这种 party game,它的本质逻辑可能都是有一批最早的老鼠仓,这批老鼠仓可能现在数据分析能力很强了,不能够直接以一些比较显而易见的方式去出售自己的资产,那么要做的东西是啥呢?假设我是一个 Layer 1 大的公链的主导者,首先我不可能明目张胆的把我的代币给它卖掉,我可能有几种办法去获利:第一种,我搞一个基金去扶持一些生态里面的项目,我可以通过卖生态项目的代币来获利,第二种,不断的去增加原生的代币的使用场景,那么参与到整个二级市场流通的份额会减少,那么我再去控制现货或者合约的价格,可能方法就更多了。那怎么样去创造原生代币的使用场景?要么就是搞一大堆生态,像上一轮周期 Terra 生态里不断的套娃,最终场内杠杆加的也很高,原生的代币也被各种各样的 staking 住,要么就像现在 Solana 一样,可能几个人攒一个新的 MEME,搞一个新的生态项目,比如发行平台,这些发行平台还有 DEX 里面,你会发现它的 trading pair 的另一侧永远是 SOL,我觉得这种逻辑其实是非常显而易见的,把几个能够出圈的项目拱起来之后,后面有更多的人也想玩 party game 的人进来,不断攒新的局。但不管攒什么样的局,主流的代币它可能都是 trading pair 的一环,那我就可以用各种各样的办法把这个币卖出去,也可以去搞 OTC,最近有一个生态 OTC 就卖了很多嘛。

FC:

我觉得欧美和亚洲现在区别在哪?其实欧美的钱是比较长的,这是实话实说。亚洲基金 2017 年的时候,周期是 6+ 6 ,就是 6 个月加 6 个月,下一轮就是 2+ 2 ? 1+ 1 , 2+ 2 ,现在是 2+ 3+n,但实际上欧美的基金基本都是 4+ 4 对吧?基本上都是 8 年周期的基金。这后面也就意味着其实大家的 LP 是不一样的,LP 对于收益的预期和时长都不一样。比如像a16z,他们一投可能投几千万美金,怎么卖呢?我也听到一个答案,就是他可能通过比如 Coinbase 有一个 OTC 的团队,专门卖给可能更长期的家办,所以我是觉得他们这一条路径就玩的还是挺成熟的。但对于亚洲来说, 2017 年 SOLANA 这些项目都是在北京去做路演的,当时我们还上过会。但现在其实没有中国市场以后,大家就没有这个优势了。其实我觉得可能有时间我觉得我们也可以再找一期聊一聊,其实现在亚洲创业者的问题是大家只能不断的发新项目,因为原有的项目可能最终上了 BN,后面就不知道做啥了,他不一定不想做,而是他不知道怎样才能做得更好。昨天还看到一条推特,说现在亚洲创业者最重要的是找到外国人,怎么跟外国人玩,或者怎么说服外国人,我觉得其实挺对的,但同样也挺寒心的。 因为我最近用了你的产品,我觉得还是挺好的。我的感受我觉得最重要的省时间,这是第一个。第二个,我们以前去扒一个团队整体的资料其实还是挺麻烦的,比如又要从 root data,又要从推特,你做的这个整合其实很重要。第三个,确实当我不知道干嘛的时候,我去你那刷一刷,其实至少会让觉得我好像今天没白忙。再有就是 MEME 这个事儿,你有很多交易信号是有帮助的。所以我觉得今天也感谢你帮我把数据这一块更完善了。

BTC波动率:一周回顾2024年9月9日–9月16日

关键指标(香港时间 9 月 9 日下午 4 点 -> 9 月 16 日下午 4 点):

-

BTC/USD + 6.9% ($ 55, 080 -> $ 58, 900) , ETH/USD -0.7% ($ 2, 320 -> $ 2, 305)

-

BTC/USD 12 月(年底)ATM 波动率 -2.9 v ( 62.4-> 59.5), 12 月 25 d 风险逆转波动率 -0.1 v ( 2.5 -> 2.4)

-

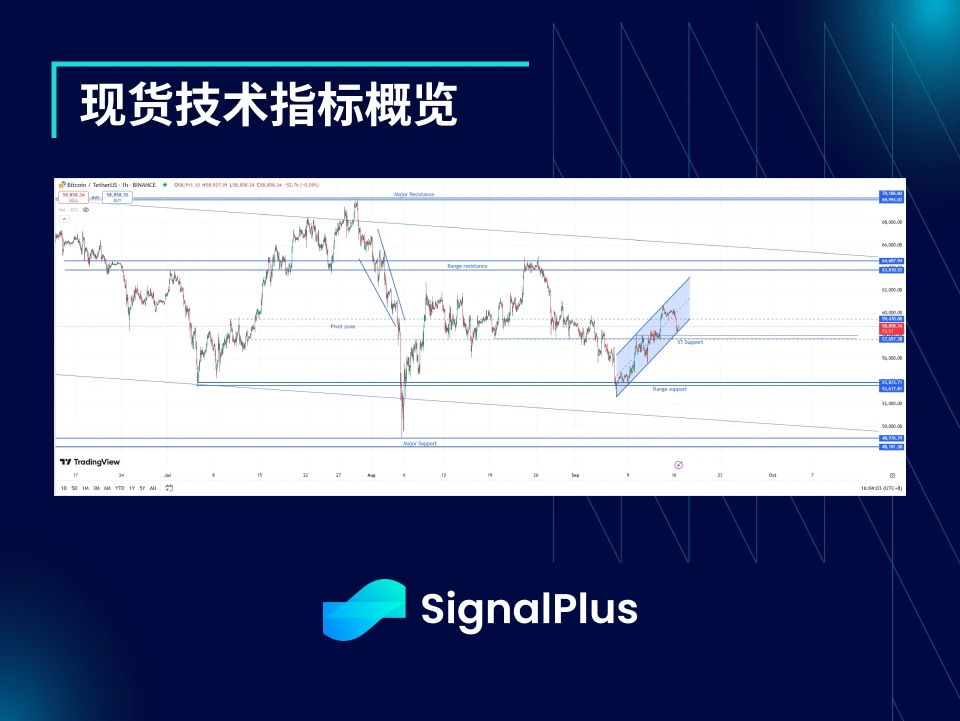

BTC/USD 在区间支撑范围强劲反弹,回升至 $ 58-60 k 关键价格区间,当前正尝试在价格波动较大的情况下寻找平衡。

-

短期走势仍然保持看涨态势,但若跌破 $ 57.5 k 支撑位,可能预示更大幅度的回调

-

若价格回落至 $ 54 k 以下,将打破长期上升的旗形形态,暗示可能会跌破 $ 50 k

-

如果价格突破 $ 61-62 k 上方,下一个主要阻力位将在 $ 65 k 附近,市场可能会在此处遇到卖压,选举前的概率仍然是 50/50

市场大事件:

-

本月初关于 “Rektember” 的担忧似乎被夸大,BTC/USD 在触及 $ 52 k 强劲支撑后,本周表现回暖,短暂突破$ 60 k。相反,ETH/USD 缺乏上涨动能,徘徊于 $ 2, 300 水平

-

9 月 10 日的总统辩论后,由于哈里斯的表现被认为优于对手,美国民调略微向其倾斜。然而,由于目前选情依然接近 50/50 ,除非选情进一步明确,否则对加密货币价格影响有限(这种情况可能要等到实际选举时才会发生)

-

本周的 FOMC 会议市场仍然在 25 个基点和 50 个基点的降息预期之间摇摆;最初在周三 CPI 数据公布后,市场完全定价了 25 个基点的降息预期,但随后一些非美联储投票成员的“泄密”信息显示 50 个基点的降息也可能成真,市场预期回归 50/50

-

美国股市再次从本地低点找到支撑,原因包括:市场仓位显然仍然相对防御,受“九月下跌潮”担忧的影响;企业盈利大多依然稳健;美国经济数据尚未出现崩溃迹象。如果美联储此时确实降息 50 个基点,预计股市和加密货币市场将进一步走高

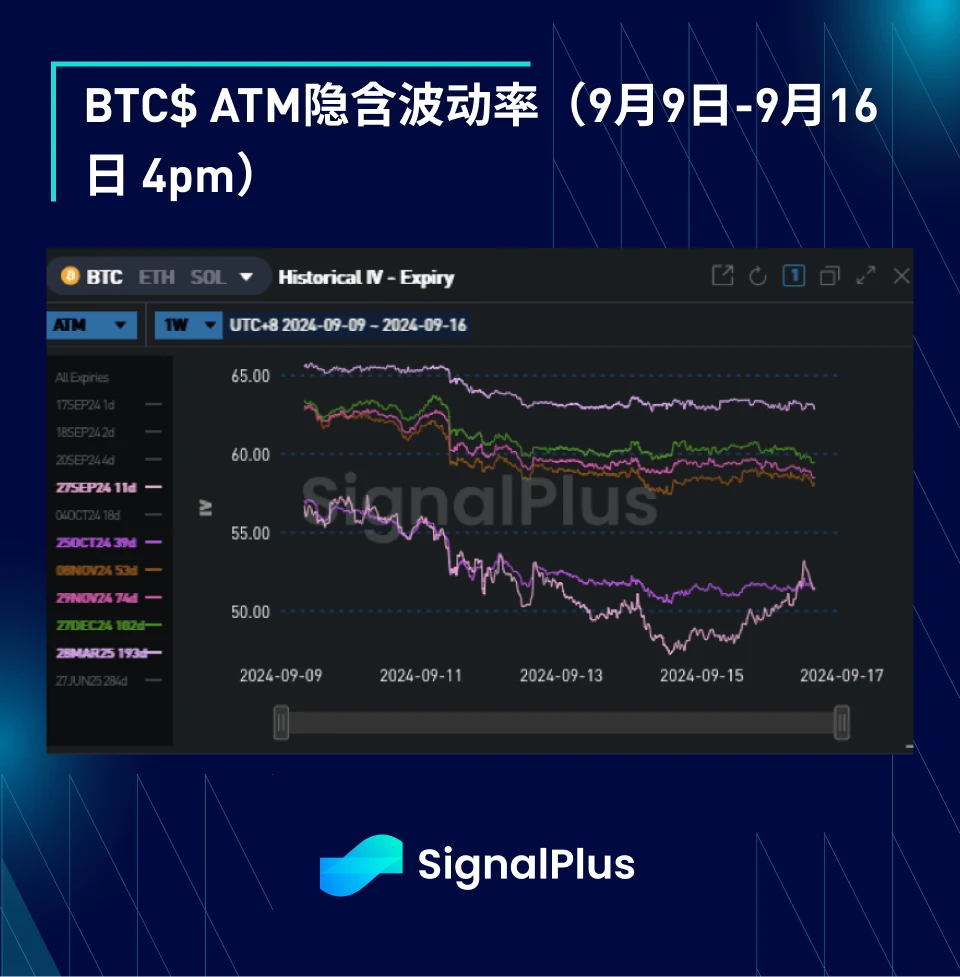

ATM 隐含波动率:

-

尽管市场对总统辩论和美国 CPI 等事件的预期溢价较高,但实际波动率在本周依然较为平淡,尽管 1 w 隐含波动率曾一度高达 60 ,但高频波动率仍维持在 40 中段。

-

在本周初期,市场对期权的需求激增,但到周末,市场出现了波动性和方向性押注的平仓,进一步压低了隐含波动率,特别是在曲线的前端。

-

由于选举结果仍为 50/50 ,选举波动率定价略微下降,符合整体波动曲线中溢价的减少,随着选举临近,我们预计波动率会有所上升。

-

选举波动率定价略微下降,与整体波动率曲线上的溢价减少相一致。由于当前选举结果的概率仍然是 50/50 ,我们预计随着事件的临近,波动率将会再次上升。

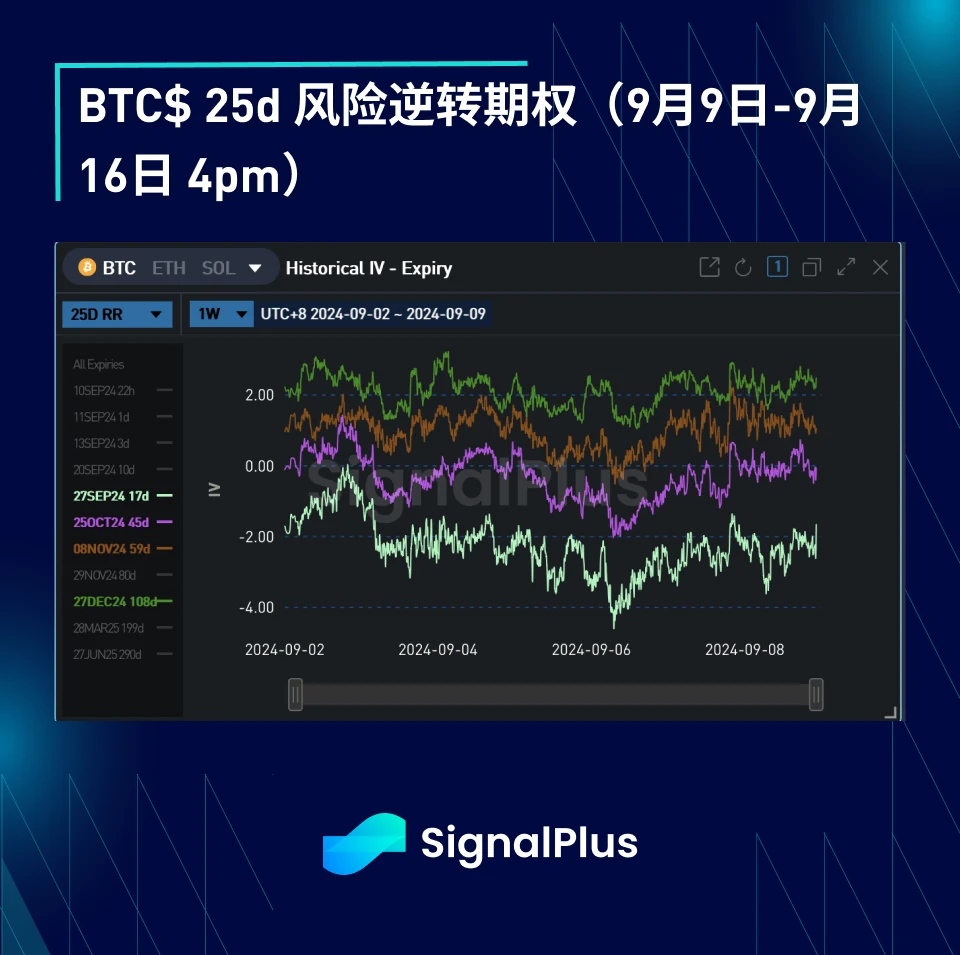

偏斜/凸性:

-

本周波动率的偏斜和和凸性走势相对平稳,市场聚焦于本月事件的局部期权需求。

-

由于隐含波动率与现货价格变动之间没有明显的相关性(即隐含波动率对现货价格的上涨或下跌反应不大),因此我们很难在选举前看到任何重大的价格调整。由于选举结果的不确定性(50/50)以及选举结果对现货价格的显著影响,我们预计在选举前,市场会对局部行权价的波动进行更多调整。

祝大家下周好运,也祝参加 Token 49 的朋友们玩得愉快!

您可在 t.signalplus.com 使用 SignalPlus 交易风向标功能,获取更多实时加密资讯。如果想即时收到我们的更新,欢迎关注我们的推特账号@SignalPlusCN,或者加入我们的微信群(添加小助手微信:SignalPlus 123)、Telegram 群以及 Discord 社群,和更多朋友一起交流互动。

SignalPlus Official Website:https://www.signalplus.com

渣打银行:特朗普胜选将导致比特币大爆发

大选的重要影响

渣打银行(STAN)周四在恢复对该领域的报道的报告中表示,无论谁赢得 11 月的美国大选,全球最大的加密货币比特币(BTC)都有望在年底前创下新高。

该行表示,美国总统大选结果对数字资产很重要,但其重要性不如拜登担任民主党候选人时那么大,也低于市场的预期。

报道称,无论谁赢得大选,比特币预计都将在年底前创下历史新高,如果特朗普获胜,比特币价格可能大爆发,达到约 125,000 美元,如果卡玛拉·哈里斯获胜,比特币价格可能达到约 75,000 美元。

渣打银行数字资产研究全球主管杰夫·肯德里克 (Geoff Kendrick) 写道:“无论谁入主白宫,放松监管方面的进展——尤其是废除SAB 121,该法案对银行的数字资产持有量施加了严格的会计规则——都将继续到 2025 年。”他补充说,在哈里斯担任总统期间,进展将需要更长的时间。

报告指出,美国国债收益率曲线再次趋陡也为比特币“营造了积极势头”。

如果哈里斯获胜,比特币最初可能会被抛售,但肯德里克预计任何下跌都将被买入,因为投资者认识到监管仍将取得进展(尽管速度较慢),并且其他积极催化剂将占据主导地位。

特朗普更利好加密

经纪商伯恩斯坦在周一的一份研究报告中表示,如果唐纳德·特朗普在 11 月赢得美国大选,比特币(BTC)预计将在今年晚些时候创下新高,到第四季度,这种加密货币可能达到 90,000 美元。

报道称,如果卡马拉·哈里斯赢得大选,预计市值最大的加密货币将突破目前 60,000 美元左右的底部而已。

该经纪人指出,特朗普一直直言不讳地要把美国打造为“世界比特币和加密货币之都”,并在每次政策演讲中都提到数字资产。

特朗普7 月份在比特币纳什维尔会议上发表讲话,呼吁美国成为比特币挖矿强国,任命一位对加密货币友好的美国证券交易委员会 (SEC) 主席,建立国家战略比特币储备库和总统加密货币咨询委员会。

相反,报道指出,哈里斯的任何演讲中都没有提到加密货币。

伯恩斯坦表示,过去三年来,加密货币市场面临两大重大阻力,即宏观阻力和监管阻力。

以 Gautam Chhugani 为首的分析师写道:“经过过去三年的监管清理,积极的加密监管政策可以再次刺激创新,并将用户带回区块链上的金融产品。”

报告补充道:“选举结果仍难预测,但如果你在这里持有加密货币多头,你很可能会进行特朗普交易。”

据以前的文章,自从现任总统拜登退出今年的大选以来,特朗普在预测中的领先势头被哈里斯赶超。

近日,民主党候选人哈里斯的竞选团队表示,自哈里斯开始竞选总统以来的一个多月,共筹集到 5.4 亿美元,其中美国民主党全国代表大会期间筹集到 8200 万美元。

哈里斯竞选团队经理认为,这表明民主党对她参选的热情。据《金融时报》报道,哈里斯 7 月份筹集的资金为 2.04 亿美元,是特朗普的 4 倍。截至 7 月底,哈里斯的竞选团队有 2.2 亿美元现金,而特朗普的竞选团队则有 1.51 亿美元现金。

根据公开报道,到目前为止,特朗普参加的竞选集会比 2016 年和 2020 年少得多,尤其在遭遇枪击事件之后。

特朗普的捐款人和朋友对一些选举决策提出了质疑,担心特朗普「毫无章法」,缺乏竞选纲领和强大的竞选行动。不过,特朗普的竞选团队表示,他们已经为 11 月份的最后冲刺做好了准备。

头牌公链项目能否在未来降息中领涨?

作者:探寻区块链趋势

公链板块,从区块链诞生至今,一直是兵家必争之地,作为区块链发展的根本,一条成功的公链,不仅会聚集市场上大部分资金和人气,还能依靠自身的生态建设左右市场的发展趋势。

以太链诞生后,智能合约开始横行天下,人人皆可发币。币安链火起来之后,粉红平台一天最多可以发售9000个项目,而后面SOL等链的成功,开启了Layer2技术竞赛,低费率,高速度成为新的公链标准。

这些项目成功的背后,是巨量的收益,催生了无数的百万千万富翁,这也是很多人进入区块链投资的动力来源,小额投资,就能获得几辈子都赚不到的财富。

但是,从FTX暴雷之后,导致SOL暴跌开始,公链项目的表现,却不尽人意,虽然项目发展都有条不紊,但诸如APT,ARB,CORE等新生公链项目,似乎都不再受普通投资者的青睐,价格持续走跌,无法找到市场的突破口。

所以,在我们准备投资公链项目前,需要明白为何现阶段如此多优质的公链项目,都无法走出如今的下跌趋势。

首先最根本的原因,在于当前熊市环境下,市场资金规模萎缩,不足以撑起这么多高市值项目。

例如ARB的发售价在$1左右,总量100亿,那么发售之初就是百亿美元市值,这会有多少涨幅空间呢?(BNB目前市值是300亿美元左右)

开盘即巅峰,相信那些在Blur开盘时挂在山顶的人肯定深有体会。

其次一点,也是现在大型公链项目的通病,前期机构和投资者持仓过多。

机构投资,是一把双刃剑,你需要机构的资金来维持项目运转,可在你接受机构投资之后,意味着需要把自己项目一大半的未来,交到机构的手上,今年的SOL,就是被FTX拖累。FTX为了填补自己的资产空缺,抛售了大量的资产。

而对散户影响最大的,有了机构投资之后,普通人就无法再获取低价的筹码了。在散户失去了以小博大的机会后,他们对这类公链项目就更提不起兴趣了。

正是在这多方面因素下,二级市场的共识者已经逐渐流失,有一些离开了币圈市场,有一些则去一级市场寻找机会。

难道散户们,再也找不到几年前那种投资ETH,BNB暴富的机会了吗?

一级市场的公链项目并不多。我们经常能看到某某公链零撸挖矿的消息,因为自从类似CORE这种项目富了一批撸空投的人之后,国内参照这个模式的项目也越来越多。但是很明显,这类项目不在小投资高回报的范畴,只能算作薅羊毛的范畴,不适合长期投资。

其次,公链项目爆发周期比一般项目要长,即便是如TX公链,由于资金问题中途被机构全资收购,虽然带来了短暂的拉高,但离暴富还有不少距离。

因为要达到SOL甚至BNB,ETH的高度,不是一两个机构投资就能解决的。

当初ETH,BNB,SOL为何会脱颖而出,是因为他们在技术上和生态上,为区块链市场注入了强大的发展基因,开拓了更宽广的发展空间。

我们应当用空闲资金,研究市场,认准,定投,稳拿,不追求那三两天暴富的机会,而是等待不久后的财富自由。

观点:加密世界应继续搞基建 而不是高估值空气基建

作者:Rickey;编译:深潮TechFlow

最近,我听到太多人抱怨以太坊的基础设施,指责风险投资公司投资了大量毫无意义的基础设施,认为过剩的基础设施导致了行业的困难,并试图在应用开发者和基础设施组织之间制造矛盾。他们似乎将以太坊生态系统描绘成一个不适合应用开发的“尼夫海姆”(Niflheim在北欧神话中是一个寒冷、黑暗、充满迷雾的世界。它通常被描述为一个不适宜生存的地方)。

这种说法非常不友好,也让人难以信服。

我们需要澄清一些误解:什么是真正的基础设施?

它是否有宏大的叙述?是否获得了顶级风险投资的支持?是否产生了大量泡沫?是否充满虚无主义?是否失去了你的投资?EBOLA(EVM 逻辑缺失症)?

真正的基础设施包括:

-

协议、EIP(以太坊改进提案)、框架、工具栈以及非应用层的区块链服务。

-

用于解决特定问题,提高应用的效率、用户体验、去中心化、安全性和隐私。

-

代码是开源的,接受社区的贡献和审查。

-

为应用开发者提供免费的方案,甚至是完整的公共产品。

-

由一群真正理想主义和乐观的人所构建。

区块链基础设施的发展

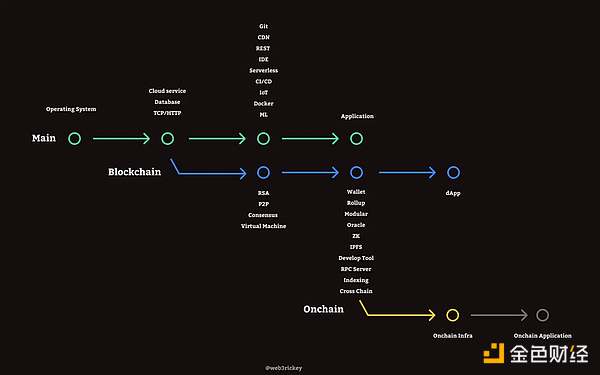

我倾向于用 git 分支的形式来描述区块链基础设施的发展。

区块链类似于一个新的 git 分支。在这个分支的第一阶段,加入了密码学、P2P 网络、共识算法等基础设施。这些基础设施可以用于构建比特币、以太坊及其他 L1 网络。

在第二阶段,各种基于以太坊的工具、设施和服务相继涌现,开发者可以利用它们构建各种钱包、DeFi 应用和 Layer2 网络。有趣的是,经过这个提交后,创建了一个链上分支。这个分支的最终目标是将用户数据完整存储在链上,并通过智能合约来实现应用的逻辑。开发者可以实现真正可验证、可组合和可互操作的链上应用程序。目前,我们正处于该分支的链上基础设施建设阶段,我认为我们走在正确的道路上。

基础设施给我们带来了什么?

1. 减少垄断

在某个特定领域,开发者有更多选择。假设你是一家初创公司的创始人,想要为你的网络提供交易数据查询服务,你愿意支付高额费用购买某公司的区块扫描服务吗,还是选择部署一个免费的 Blockscout?

2. 提高效率

开发者将迁移到更高效的工具和基础设施。这是我在过去一年中应用技术栈的变化:

链:Tendermint → OP Stack

开发工具:Truffle/Hardhat → Foundry

合约交互:Web3.js / Ether.js → Viem

存储:IPFS → BNB Greenfield

区块浏览器:Etherscan → Blockscout

钱包:扩展钱包 → Coinbase Smart Wallet / AA

3. 丰富应用程序的多样性

为开发者提供足够的基础设施,以便他们创建有趣的应用。几年前,我们主要在以太坊生态系统中构建 DeFi 和 NFT 相关的应用。现在,你可以利用各种基础设施来构建更有趣的产品和应用:

云平台:Fleek

身份验证:Privy

游戏:MUD, Dojo, Paima

钱包工具包:Onchain Kit, rainbowkit

开源奖励:tea

全栈 ZK 证明服务:polyhedra

以太坊的无信任 AI:ora

IP:StoryProtocol

4. 降低应用程序的启动成本

实际上,你只需支付部署合约的 gas 费用。由于基础设施足够完善,连小型开发团队也能快速整合基础设施服务,实现预期功能。几乎所有基础设施服务提供商都会为开发者提供免费计划,这些计划足以支持和验证你的早期想法。

5. 加速大众的采用

这取决于基础设施带给非金融化应用和用户体验的变化。我认为这也是许多开发者从开发消费者加密应用转向开发基础设施的原因。并不是说开发者过于关注技术,而是他们必须首先解决效率和用户体验之间的摩擦问题,然后再构建应用来验证其可行性。

我们可能需要经历几个阶段才能实现真正的大规模采用基础设施爆炸期:同一领域出现多种不同的解决方案,类似于 Layer2 的 OP、ZK、ZKEVM 和 Plasma。基础设施淘汰期:市场将淘汰那些没有实际意义且仅依赖代币的基础设施。基础设施稳定期:一些真正有价值的基础设施将得以存活,开发者开始基于这些基础设施构建各种类别的消费应用。大众采用:此阶段的区块链基础设施与 Web2 服务提供给消费者的用户体验相同。用户不需要了解区块链的工作原理就能使用各种应用,这可以为用户带来更好的利益分配、数字资源的拥有权、隐私和反审查能力。

6. 降低中心化的影响

想象一下,如果我们所有的应用程序都使用同一基础设施服务,直到某一天,某个国家的政府将其关闭,甚至逮捕其核心代码贡献者或首席执行官,使得无法为应用提供服务。但我们的基础设施服务是充足的,还有其他可替代的解决方案,因此,应用程序不会因某个基础设施的瘫痪而停止运行。

继续建设基础设施

“你想一辈子卖糖水,还是想和我一起改变世界?”这是史蒂夫·乔布斯对百事可乐高管约翰·斯卡利说的话,以吸引他加盟苹果。

现在我想问你一个问题:

“你想一辈子制作和交易 Memecoin,还是想建立基础设施并改变加密世界?”

基础设施是行业的动力,它带来了新的叙事和愿景,即使这仅仅是一个新的标准、一个提案或一个 SDK。无数的建设者需要故事来坚定他们的信念并保持热情。我们为什么相信加密?为什么相信链上?成为建设大教堂的人。如果你不认为自己在建设大教堂,那就换一份工作。